в каком году был создан голосовой помощник

Голосовые помощники: эволюция, устройство и основные игроки

Уточнить у Siri рецепт сырников во время готовки или попросить Алису прочитать сказку — вполне привычные для нашей жизни сценарии. А как это работает? Как звук превращается в понятные виртуальному помощнику команды, которые сразу же исполняются? Кто главные игроки на рынке? Какие еще заботы могут снять с нас голосовые помощники?

Редакция DTI Algorithmic собрала ответы на все эти вопросы — и помогали нам в этом наши программисты и союзники. В результате получился информационно насыщенный лонгрид, который мы будем публиковать по частям. Сегодня — про эволюцию голосовых помощников, их устройство и основных игроков на рынке.

Эволюция голосовых помощников

История голосовых ассистентов начинается с конца 1930-х годов, когда ученые начали предпринимать попытки распознать голос силами технологий. Тогда созданию качественного помощника мешали две большие проблемы:

Сейчас для решения этих проблем разработчики используют машинное обучение. Оно учит нейронные сети самостоятельно анализировать контекст и эффективно определять основной источник звука. Однако пришли разработчики к этому не сразу — потребовалось как минимум 80 лет подготовительных работ:

1939 год. Советский физик Лев Мясников создал аппарат, способный распознавать человеческую речь — несколько гласных и согласных звуков.

1952 год. Сотрудники лаборатории Bell разработали механизм, который распознавал продиктованные по телефону числа от 1 до 9.

1962 год. Компания IBM представила собственную технологию распознавания речи — Shoebox. Машина распознавала 16 английских слов, 10 цифр и 6 арифметических команд.

1980 год. Инженеры научились применять методы «Скрытой модели Маркова». Со временем это позволило голосовым системам лучше распознавать речь. Они обрабатывают слово, учитывая несколько предыдущих и предсказывая, что может с ними сочетаться.

1987 год. В США компания Worlds of Wonder начала продавать говорящую куклу Джулию, которая училась распознавать речь ребенка во время игры. В куклу был встроен процессор, который позволял ей реагировать и генерировать речь. Джули воспринимала восемь высказываний: «Джули», «да», «нет», «хорошо», «притворяйся», «голодна», «пой» и «молчи».

1990-е годы. Появилась коммерческая программа Dragon Dictate, ориентированная на массовый рынок. Она распознавала речь и записывала надиктованный текст в файл.

1996 год. Появилось полноценное голосовое меню VAL от BellSouth. Система обрабатывала телефонные справочные запросы и помогала покупателям в поиске нужной информации об интересующих товарах.

Позже компания запустила Info by Voice — интерактивные голосовые «желтые страницы» с информацией о ближайших ресторанах, такси и некоторых магазинах. Система также могла рассказать о новостях и котировках акций, погоде, телепрограмме, гороскопе и спортивных событиях.

2001 год. Компания Microsoft добавила голосовой ввод текста в офисный пакет Office XP.

2002 год. Google запустил Voice Search — сервис для голосового поиска в интернете. Проект приостановили из-за неудобства использования — чтобы выполнить поиск, надо было позвонить на специальный номер. На Voice Search основан современный интерактивный помощник компании — Google Assistant.

2007 год. Центр исследования искусственного интеллекта SRI International начал разработку Siri. Siri стала первой голосовой помощницей — система умела не только искать информацию в интернете или работать как голосовое меню, но и вести с пользователем диалог.

2011-2014 годы. Google интегрировал функцию голосового поиска в браузер Chrome. Компания также запустила персонализированного ассистента Google Now с расширенными возможностями голосового поиска — сервис подбирал актуальную информацию с учетом местоположения пользователя, истории браузера и других поисковых запросов.

У Microsoft также появилась собственная виртуальная голосовая помощница — Cortana.

2014 год. Amazon представил первую в мире умную колонку Amazon Echo с голосовой ассистенткой Alexa.

2017 год. Alibaba представила умную колонку Tmall Genie с голосовым помощником AliGenie.

2018 год. Яндекс выпустил умную колонку Яндекс.Станция с голосовой помощницей Алисой.

2019 год. Банк «Тинькофф» запустил собственного голосового ассистента «Олега». Mail.Ru Group представила голосовую помощницу «Марусю».

Как устроены современные голосовые помощники

Голосовые помощники пассивно считывают все звуковые сигналы, и для активной работы им необходима активация при помощи кодовой фразы. Например, произнесите: «Окей, Google», потом можете задать свой вопрос или отдать команду без пауз.

В момент голосового запроса автоматическая система распознавания речи (ASR system) преобразовывает звуковой сигнал в текст. Это происходит в четыре этапа:

Если после обработки запроса виртуальный помощник не понимает команду или не может найти ответ, он просит перефразировать вопрос. В некоторых случаях могут понадобиться дополнительные данные — например, при вызове такси ассистент может уточнить местоположение пассажира и пункт назначения.

Основные игроки на рынке

По данным Microsoft, самые популярные голосовые помощники в США — Google Assistant, Siri от Apple, Alexa от Amazon и Cortana от Microsoft. Русский язык из них понимают только первые два, однако на российском рынке также работает Алиса от Яндекса, а на китайском — AliGenie от Alibaba. Сравнили основные характеристики умных колонок с поддержкой этих пяти голосовых ассистентов:

Как устроена Алиса. Лекция Яндекса

В этой лекции впервые рассматриваются технологические решения, на основе которых работает Алиса — голосовой помощник Яндекса. Руководитель группы разработки диалоговых систем Борис Янгель hr0nix рассказывает, как его команда учит Алису понимать желания пользователя, находить ответы на самые неожиданные вопросы и при этом вести себя прилично.

— Я расскажу, что внутри у Алисы. Алиса большая, в ней много компонент, поэтому я немного поверхностно пробегусь.

Алиса — голосовой помощник, запущенный Яндексом 10 октября 2017 года. Она есть в приложении Яндекса на iOS и Android, а также в мобильном браузере и в виде отдельного приложения под Windows. Там можно решать свои задачи, находить информацию в формате диалога, общаясь с ней текстом или голосом. И есть киллер-фича, которая сделала Алису довольно известной в рунете. Мы пользуемся не только заранее известными сценариями. Иногда, когда мы не знаем, что делать, мы используем всю мощь deep learning, чтобы сгенерировать ответ от имени Алисы. Это получается довольно забавно и позволило нам оседлать поезд хайпа.

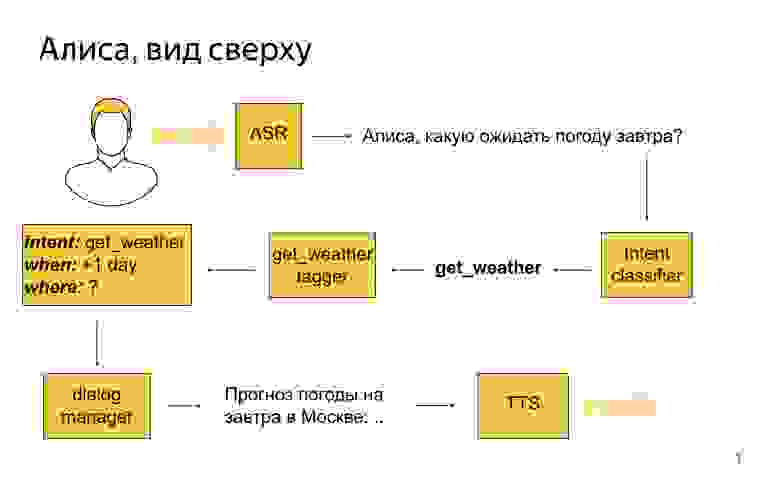

Как выглядит Алиса высокоуровнево?

Пользователь говорит: «Алиса, какую ожидать завтра погоду?»

Первым делом мы его речь стримим в сервер распознавания, он превращает ее в текст, и этот текст затем попадает в сервис, разработкой которого занимается моя команда, в такую сущность, как классификатор интентов. Это машиннообученная штука, задача которой — определить, чего же пользователь хотел сказать своей фразой. В этом примере классификатор интентов мог сказать: окей, наверное, пользователю нужна погода.

Затем для каждого интента есть специальная модель, которая называется семантический теггер. Задача модели — выделить полезные крупицы информации в том, что сказал пользователь. Теггер для погоды мог бы сказать, что завтра — это дата, на которую пользователю нужна погода. И все эти результаты разбора мы превращаем в некоторое структурированное представление, которое называется фреймом. В нем будет написано, что это интент погода, что погода нужна на +1 день от текущего дня, а где — неизвестно. Вся эта информация попадает в модуль dialog manager, который, помимо этого, знает текущий контекст диалога, знает, что происходило до этого момента. Ему на вход поступают результаты разбора реплики, и он должен принять решение, что с ними сделать. Например, он может сходить в API, узнать погоду на завтра в Москве, потому что геолокация пользователя — Москва, хоть он ее и не указал. И сказать — сгенерируйте текст, который описывает погоду, затем его отправить на модуль синтеза речи, который с пользователем поговорит прекрасным голосом Алисы.

Dialog Manager. Здесь нет никакого машинного обучения, никакого reinforcement learning, там только конфиги, скрипты и правила. Это работает предсказуемо, и понятно, как это поменять, если нужно. Если менеджер приходит и говорит, поменяйте, то мы можем это сделать в короткие сроки.

В основе концепции Dialog Manager лежит концепция, известная тем, кто занимается диалоговыми системами, как form-filling. Идея в том, что пользователь своими репликами как бы заполняет некую виртуальную форму, и когда он в ней заполнит все обязательные поля, его потребность можно удовлетворить. Движок event-driven: каждый раз, когда пользователь что-то делает, происходят какие-то события, на которые можно подписываться, писать их обработчики на Python и таким образом конструировать логику диалога.

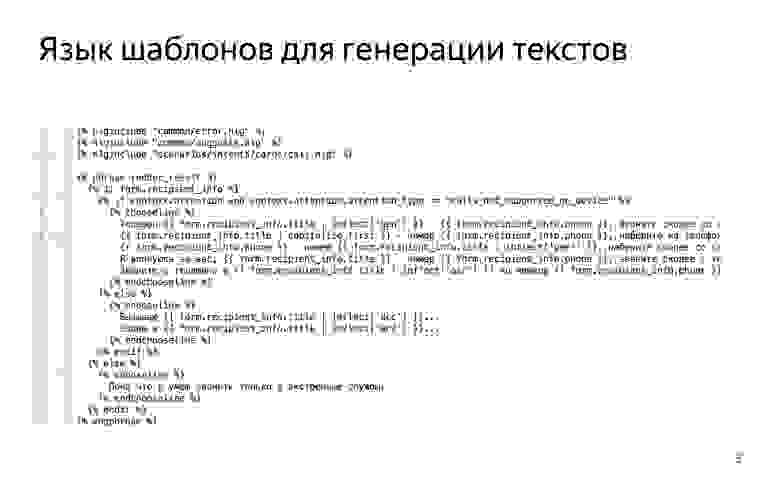

Когда нужно в сценариях сгенерировать фразу — например, мы знаем, что пользователь говорит про погоду и нужно ответить про погоду, — у нас есть мощный язык шаблонов, который позволяет нам эти фразы писать. Вот так это выглядит.

Это надстройка над питонячьим шаблонизатором Jinja2, в которую добавили всякие лингвистические средства, например возможности склонять слова или согласовывать числительные и существительные, чтобы можно было легко когерентный текст писать, рандомизировать кусочки текста, чтобы увеличивать вариативность речи Алисы.

В классификаторе интентов мы успели попробовать множество разных моделей, начиная от логистической регрессии и заканчивая градиентным бустингом, рекуррентными сетями. В итоге остановились на классификаторе, который основан на ближайших соседях, потому что он обладает кучей хороших свойств, которых у других моделей нет.

Например, вам часто надо иметь дело с интентами, для которых у вас есть буквально несколько примеров. Просто учить обычные классификаторы мультиклассовые в таком режиме невозможно. Например, у вас оказывается, что во всех примерах, которых всего пять, была частица «а» или «как», которой не было в других примерах, и классификатор находит самое простое решение. Он решает, что если встречается слово «как», то это точно этот интент. Но это не то, чего вы хотите. Вы хотите семантической близости того, что сказал пользователь, к фразам, которые лежат в трейне для этого интента.

В итоге мы предобучаем метрику на большой датасете, которая говорит о том, насколько семантически близки две фразы, и потом уже пользуемся этой метрикой, ищем ближайших соседей в нашем трейнсете.

Еще хорошее качество этой модели, что ее можно быстро обновлять. У вас появились новые фразы, вы хотите посмотреть, как изменится поведение Алисы. Все, что нужно, это добавить их множество потенциальных примеров для классификатора ближайших соседей, вам не нужно переподбирать всю модель. Допустим, для нашей рекуррентной модели это занимало несколько часов. Не очень удобно ждать несколько часов, когда вы что-то меняете, чтобы увидеть результат.

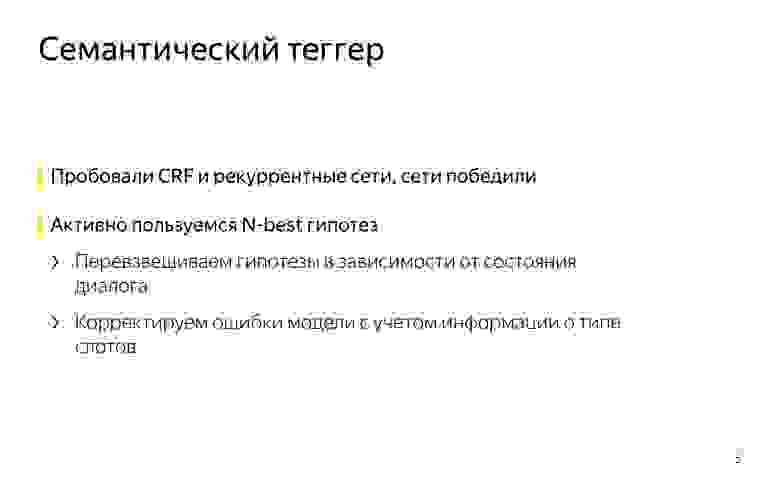

Семантический теггер. Мы пробовали conditional random fields и рекуррентные сети. Сети, конечно, работают намного лучше, это ни для кого не секрет. У нас там нет уникальных архитектур, обычные двунаправленные LSTM с attention, плюс-минус state-of-the-art для задачи тегирования. Все так делают и мы так делаем.

Единственное, мы активно пользуемся N-best гипотез, мы не генерируем только самую вероятную гипотезу, потому что иногда нам нужна не самая вероятная. Например, мы перевзвешиваем зачастую гипотезы в зависимости от текущего состояния диалога в dialog manager.

Если мы знаем, что на предыдущем шаге мы задали вопрос про что-то, и есть гипотеза, где теггер что-то нашел и гипотеза, где не нашел, то наверное, при прочих равных первое более вероятно. Такие трюки нам позволяют немного улучшить качество.

А еще машиннообученный теггер иногда ошибается, и не совсем точно в самой правдоподобной гипотезе находят значение слотов. В этом случае мы ищем в N-best гипотезу, которая лучше согласуется с тем, что мы знаем о типах слотов, это позволяет тоже еще немного качество заработать.

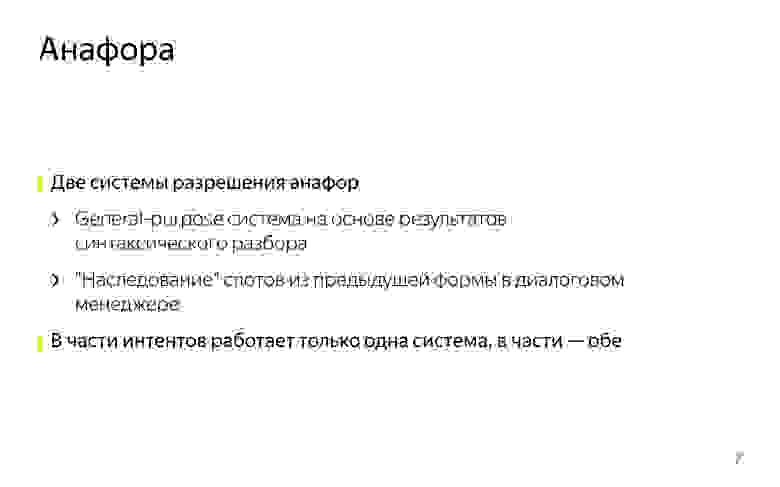

Еще в диалогах есть такое явление Анафора. Это когда вы с помощью местоимения ссылаетесь на какой-то объект, который был раньше в диалоге. Скажем, говорите «высота Эвереста», и потом «в какой стране он находится». Мы анафоры умеем разрешать. Для этого у нас две системы.

Одна general-purpose система, которая может работать на любых репликах. Она работает поверх синтаксического разбора всех пользовательских репликах. Если мы видим местоимение в его текущей реплике, мы ищем known phrases в том, что он сказал раньше, считаем для каждой из них скорость, смотрим, можно ли ее подставить вместо этого местоимения, и выбираем лучшую, если можем.

А еще у нас есть система разрешения анафор, основанная на form filling, она работает примерно так: если в предыдущем интенте в форме был геообъект, и в текущем есть слот для геообъекта, и он не заполнен, и еще мы в текущий интент попали по фразе с местоимением «туда», то наверное, можно предыдущий геообъект импортировать из формы и подставить сюда. Это простая эвристика, но производит неплохое впечатление и круто работает. В части интентов работает одна система, а в части обе. Мы смотрим, где работает, где не работает, гибко это настраиваем.

Есть эллипсис. Это когда в диалоге вы опускаете какие-то слова, потому что они подразумеваются из контекста. Например, вы можете сказать «расскажи погоду», а потом «а на выходных?», имея в виду «расскажи погоду на выходных», но вы хотите повторять эти слова, потому что это ни к чему.

С эллипсисами мы тоже умеем работать примерно следующим образом. Эллиптические фразы или фразы-уточнения — это отдельные интенты.

Если есть интент get_weather, для которого в трейне фразы типа «расскажи погоду», «какая сегодня погода», то у него будет парный интент get_weather_ellipsis, в котором всевозможные уточнения погоды: «а на завтра», «а на выходные», «а что там в Сочи» и так далее. И эти эллиптические интенты в классификаторе интентов на равных конкурируют со своими родителями. Если вы скажете «а в Москве?», классификатор интентов, например, скажет, что с вероятностью 0,5 это уточнение в интенте погода, и с вероятностью 0,5 уточнение в интенте поиска организаций, например. И затем диалоговый движок перевзвешивается scores, которые назначил классификатор интентов, который назначил их с учетом текущего диалога, потому что он, например, знает, что до этого шел разговор о погоде, и вряд ли это было уточнение про поиск организаций, скорее это про погоду.

Такой подход позволяет обучаться и определять эллипсисы без контекста. Вы можете просто откуда-то набрать примеров эллиптических фраз без того, что было раньше. Это довольно удобно, когда вы делаете новые интенты, которых нет в логах вашего сервиса. Можно или фантазировать, или чего-то придумывать, или пытаться на краудсорсинговой платформе собрать длинные диалоги. А можно легко насинтезировать для первой итерации таких эллиптических фраз, они будут как-то работать, и потом уже собирать логи.

Вот жемчужина нашей коллекции, мы называем ее болталкой. Это та самая нейросеть, которая в любой непонятной ситуации чего-то от имени Алисы отвечает и позволяет вести с ней зачастую странные и часто забавные диалоги.

Болталка — на самом деле fallback. В Алисе это работает так, что если классификатор интентов не может уверенно определить, чего хочет пользователь, то другой бинарный классификатор сперва пытается решить — может, это поисковый запрос и мы найдем что-то полезное в поиске и туда отправим? Если классификатор говорит, что нет, это не поисковый запрос, а просто болтовня, то срабатывает fallback на болталку. Болталка — система, которая получает текущий контекст диалога, и ее задача — сгенерировать максимально уместный ответ. Причем сценарные диалоги тоже могут являться частью контекста: если вы говорили про погоду, а потом сказали что-то непонятное, сработает болталка.

Это позволяет нам делать вот такие штуки. Вы спросили про погоду, а потом болталка ее как-то прокомментировала. Когда работает, выглядит очень круто.

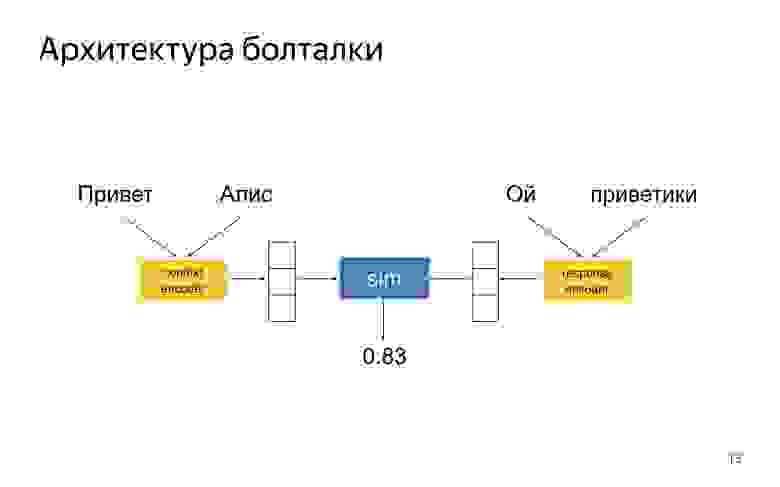

Болталка — DSSM-подобная нейронная сеть, где есть две башни энкодера. Один энкодер кодирует текущий контекст диалога, другой — ответ-кандидат. У вас получается два embedding-вектора для ответа и контекста, и сеть обучается так, чтобы косинусное расстояние между ними было тем больше, чем уместнее данный ответ в контексте и чем неуместнее. В литературе эта идея давно известна.

Почему у нас вроде неплохо все работает — кажется, что чуть лучше, чем в статьях?

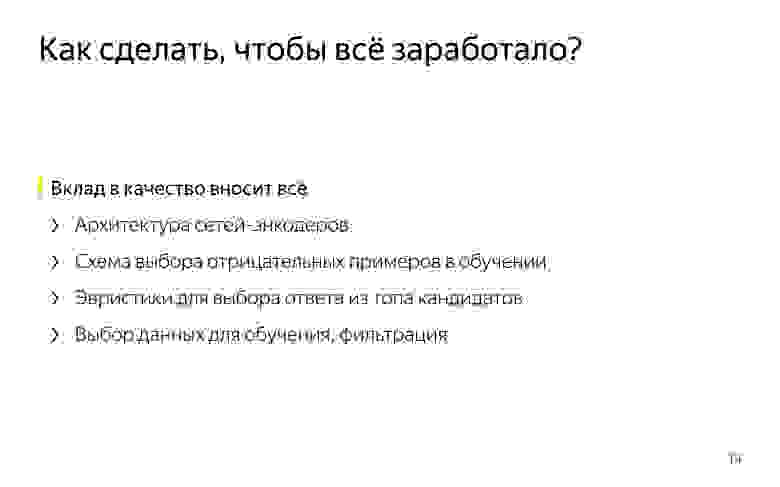

Никакой серебряной пули нет. Нет техники, которая позволит внезапно сделать классно разговаривающую нейронную сеть. Нам удалось достичь неплохого качества, потому что мы в качестве понемножку выиграли везде. Мы долго подбирали архитектуры этих башен-энкодеров, чтобы они лучше всего работали. Очень важно правильно подобрать схему сэмплирования отрицательных примеров в обучении. Когда вы обучаетесь на диалоговых корпусах, у вас есть только положительные примеры, которые когда-то кем-то были сказаны в таком контексте. А отрицательных нет — их нужно как-то генерировать из этого корпуса. Там есть много разных техник, и одни работают лучше, чем другие.

Важно, как вы выбираете ответ из топа кандидатов. Можно выбирать наиболее вероятный ответ, предлагаемый моделью, но это не всегда лучшее, что можно сделать, потому что при обучении модель учитывала не все характеристики хорошего ответа, которые существуют с продуктовой точки зрения.

Ещё очень важно, какими дата-сетами вы пользуетесь, как их фильтруете.

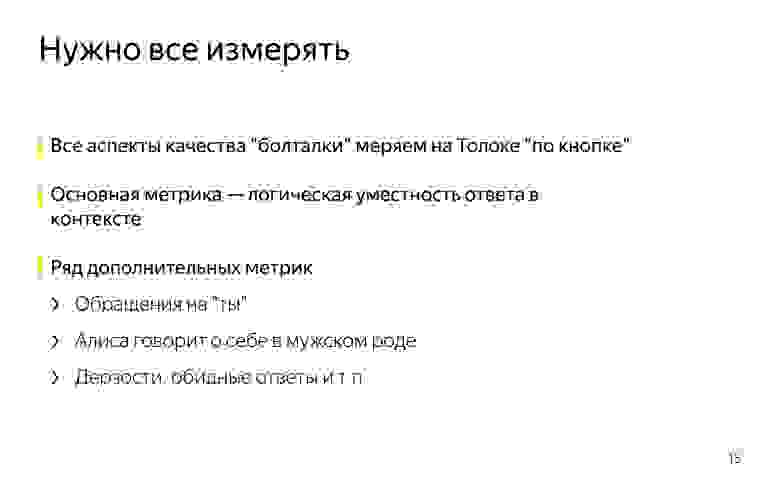

Чтобы по крупицам собрать из этого всего качество, надо уметь измерять все, что вы делаете. И тут наша гордость состоит в том, что все аспекты качества системы мы умеем мерить на нашей краудсорсинговой платформе по кнопке. Когда у нас появляется новый алгоритм генерации результатов, мы в несколько кликов можем сгенерировать ответ новой модели на специальном тестовом корпусе. И — померить все аспекты качества полученной модели в Толоке. Основная метрика, которой мы пользуемся, — логическая уместность ответов в контексте. Не надо говорить чушь, которая никак с этим контекстом не связана.

Есть ряд дополнительных метрик, которые мы стараемся оптимизировать. Это когда Алиса к пользователю на «ты» обращается, говорит о себе в мужском роде и произносит всякие дерзости, гадости и глупости.

Высокоуровнево я рассказал все, что хотел. Спасибо.

Эволюция голосовых помощников – из смартфонов в космос

О них сегодня многие говорят, чуть меньше — их используют и совсем мало кто точно знает, что они из себя представляют. Product owner Calltouch Ксюша Федоринина рассказала о том, как изменилась сфера применения голосовых помощников.

Современные технологии делают нашу жизнь проще. Ещё в начале 2000-х мы пользовались кнопочными мобильными телефонами, в интернет выходили только с компьютеров и даже не мечтали о том, чтобы заказывать такси или доставку еды в офис буквально в один клик. За прошедшие 20 лет смартфон стал универсальным инструментом для решения многих задач, и то, что раньше было недоступно, сегодня никого не удивляет.

Аналогичная ситуация и с голосовыми помощниками. Могли ли мы представить ещё десять лет назад, что по голосовой команде можно будет включить либо погасить свет в комнате или построить оптимальный маршрут до работы? А сегодня, например, по данным Pew Research Center, различные голосовые помощники использует практически каждый второй американец (46%), а аналитики Juniper прогнозируют увеличение числа устройств, оснащённых этой технологией, в США до 870 млн к 2022 году. Россияне тоже голосуют за: согласно результатам исследования Mail.ru Group, 78% наших соотечественников считают, что в будущем голосовые помощники станут неотъемлемой частью жизни.

Имена Siri и Алиса сегодня у всех на слуху, технология постоянно совершенствуется и охватывает всё новые сферы, и мы как компания, работающая на IT-рынке, решили проследить историю развития голосовых помощников.

Что под капотом у голосовых помощников

Голосовые помощники работают на базе технологии синтеза и распознавания речи, а под капотом у них движок, состоящий из нейросети, который обучают различным сценариям диалога, или платформа с набором правил.

Стоимость разработки голосового помощника зависит от его функциональности. Базовый набор, позволяющий решению озвучивать справочную информацию и решать заданные задачи, обойдётся компании в несколько миллионов рублей. Разработка более умных решений потребует более значительных затрат.

Голосовые помощники для решения бытовых задач

Первым популярным голосовым помощником стала упомянутая уже Siri от Apple, появившаяся на iPhone 4S, выпущенном на рынок в октябре 2011 года. Чуть позже, в мае 2012 года, другой интернет-гигант — Google — представил свой голосовой помощник Google Assistant. Решения обладают примерно одинаковым функционалом — умеют отправлять сообщения и совершать звонки, создавать записи в календаре, показывать погоду, открывать приложения, включать музыку, отвечать на вопросы и многое другое. И всё это – по голосовой команде владельца смартфона. Чтобы озадачить Siri или Google Assistance, достаточно произнести “Hey Siri” или “OK Google”.

Есть и другие примеры: Microsoft разработал голосовой помощник Cortana, Samsung – Bixby.

Но на самом деле, запустив Siri, Apple не открыла Америку: история голосовых помощников началась задолго до 2011 года. Уже в 1962 году IBM представила решение Shoebox, которое умело распознавать 16 слов и десять цифр (от 0 до 9). А решение Harpy, созданное учёными университета Карнеги – Меллон в 1970-х, распознавало уже 1011 слов, что соответствует словарному запасу трёхлетнего ребёнка. В 1993 году Apple выпустила Macintosh с технологией PlainTalk, а в апреле 1997 года Dragon представила решение, позволяющее превращать в текст до 100 слов в минуту.

Пока пользователи смартфонов с упоением общались с Siri, Google Assistant и другими голосовыми помощниками, компании разрабатывали подобные решения для умного дома.

В ноябре 2014 года Amazon представила смарт-динамик Alexa. Через два года, в ноябре 2016-го, подтянулась Google с Google Home, а в феврале 2018 года на этот рынок вошла и Apple, представив Apple HomPod.

Смарт-динамики могут отвечать на вопросы, включать музыку, совершать звонки, читать новости и так далее. Отдать поручение им тоже можно одним-двумя словами (в зависимости от бренда): “Alexa”, “Hey Google” или “Hey Siri”.

Подобные устройства сегодня можно увидеть и в отелях. Там смарт-динамики позволяют управлять освещением в номере, а также делать в номер заказы.

На нашем рынке голосовых помощников безусловное лидерство принадлежит Алисе от Яндекса. Он был запущен в октябре 2017 года и сегодня не только интегрирован в сервисы компании, но и используется в устройствах других производителей: смарт-колонках, умных часах, наушниках.

Но велика вероятность того, что в ближайшее время у Алисы появятся конкуренты: о разработке собственных голосовых помощников заявляли Mail.ru Group, «Тинькофф Банк» и «Центр речевых технологий» (ЦРТ). И это не может не радовать, ведь наличие конкуренции всегда на руку конечным пользователям.

Mail.ru Group уже представила голосовой помощник Маруся на встрече с премьер-министром Дмитрием Медведевым, отметив, что он будет помогать пользователям в повседневной жизни: узнавать расписание транспорта, афишу кинотеатров, результаты спортивных состязаний, искать рецепты блюд и так далее.

«Тинькофф Банк» решил выделиться на фоне конкурентов — его голосовой помощник носит мужское имя Олег. Среди его функций — осуществление денежных переводов, заказ билетов в театр и кино, бронирование столиков в ресторанах.

Не отстаёт и государственный сектор: недавно стало известно, что портал «Госуслуги Бизнес» для малых и средних предпринимателей в скором времени обзаведётся своим голосовым помощником, который сможет удовлетворить практически все потребности пользователей в сфере получения госуслуг: от отслеживания статусов поданных заявок до онлайн-общения с представителями государственных органов. Имени у решения пока нет, но надежды на него возложены немалые.

Голосовые помощники для решения задач бизнеса

Компании сегодня только «пробуют на вкус» новую технологии — бизнес использует голосовые помощники не так активно, как частные пользователи. Однако постепенно они внедряются во всё новых компаниях, пусть распространение идёт и не так быстро, как хотелось бы.

Например, голосовые помощники очень полезны во время коллективных обсуждений. Участникам не нужно отвлекаться на то, чтобы найти необходимые данные или позвонить коллеге, — это можно поручить голосовому помощнику. Также он может делать заметки и записывать все разговоры, переводя их в текст. Всё это позволяет сотрудникам сосредоточиться на теме собрания, не отвлекаясь на подобные моменты.

Кроме того, такие решения незаменимы для обеспечения высокого уровня клиентского сервиса, а это сегодня must-have для любого бизнеса. И мы в Calltouch постоянно совершенствуем это направление.

Недавно в продукте Calltouch Предикт мы реализовали такую фичу, как перевод разговоров в текст. Это открыло перед нашими партнёрами новые возможности. Например, можно быстро проанализировать запросы клиентов, работая над запуском нового продукта, или (не менее быстро) оценить эффективность сотрудников колл-центра, узнав, доносят ли они до клиентов необходимую информацию. Дополнительный бонус: звонки от мужчин и от женщин в тексте подсвечиваются разными цветами, так что на то, чтобы понять, кто чаще звонит в компанию, потребуется буквально несколько секунд. Отталкиваясь от этой информации, можно корректировать объявления и настраивать параметры таргетированной рекламы и в конечном итоге более эффективно распределять рекламный бюджет. Подробнее об этом мы рассказывали здесь.

На повышение клиентского сервиса работает и другая наша фича — синтез речи в виджете обратного звонка. Если эта опция включена, оператору колл-центра будет предложено предварительно прослушать голосовое сообщение о параметрах обращения: с какого сайта, какого виджета и в какое время оно было сделано и т. д. Это позволит персонализировать подход к клиенту и избавить его от необходимости отвечать на ряд вопросов, обычных в таких случаях, а также оперативно предоставить интересующую информацию без переключения с одного оператора на другого.

Будущее голосовых помощников

Технологии развиваются очень быстрыми темпами и становятся всё умнее, поэтому, опираясь на прогнозы аналитиков, можно с уверенностью сказать, что со временем проникновение голосовых помощников будет только повышаться. Люди быстро привыкают к вещам, которые предоставляют им принципиально новый уровень комфорта и удобства и открывают новые горизонты.

Кроме того, скоро голосовые помощники начнут освоение космоса. Сегодня космонавты читают инструкции с ноутбука, что отнимает много времени. Но уже существует робот, который сможет следить за их действиями и давать пошаговое руководство для выполнения поставленных задач. Также с его помощью космонавты всегда будут на связи с Землёй — система будет передавать им последние новости в режиме реального времени.

Немаловажно, что распространение голосовых помощников способствует повышению их эффективности, ведь подобные системы работают на базе искусственного интеллекта и способны самообучаться, а это значит, что с чем большим количеством пользователей они будут «общаться», тем умнее будут становиться.

А какими голосовыми помощниками пользуетесь вы?