что такое анонимные отчеты о синтезе речи

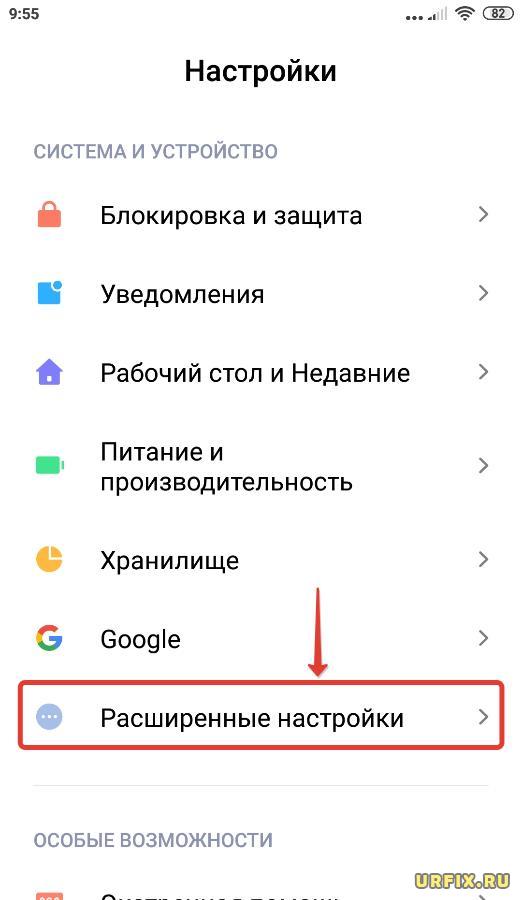

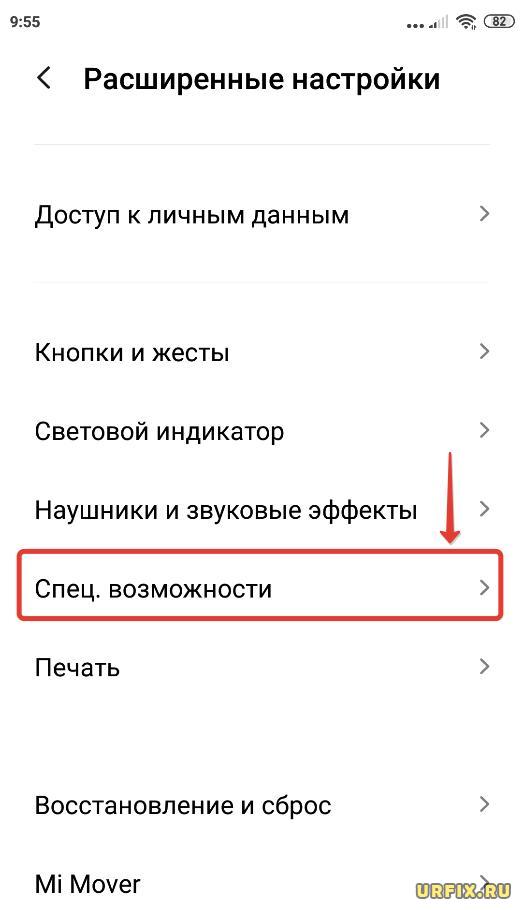

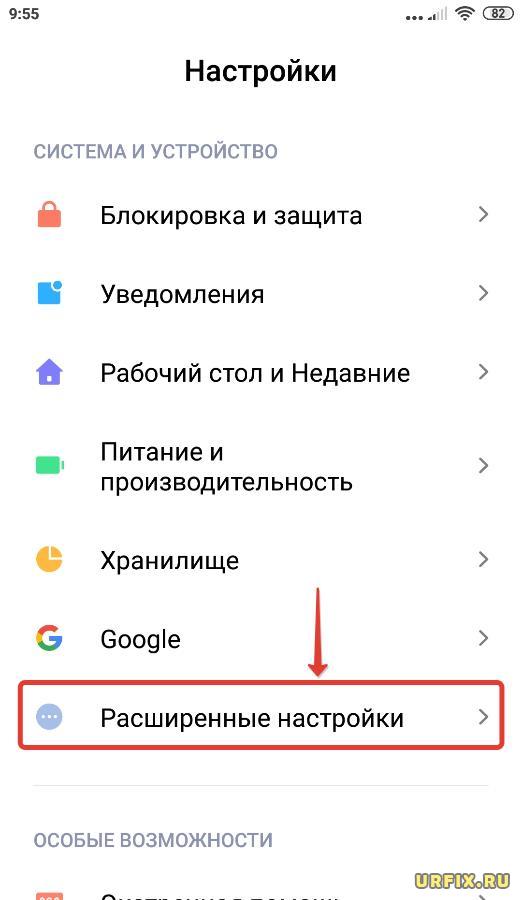

MIUI 12 и MIUI 11: Запрещаем Google собирать данные

Да, действительно, подобная проблема со временем может появиться, а один из возможных вариантов её решения прост и не требует сбросов и сложных манипуляций.

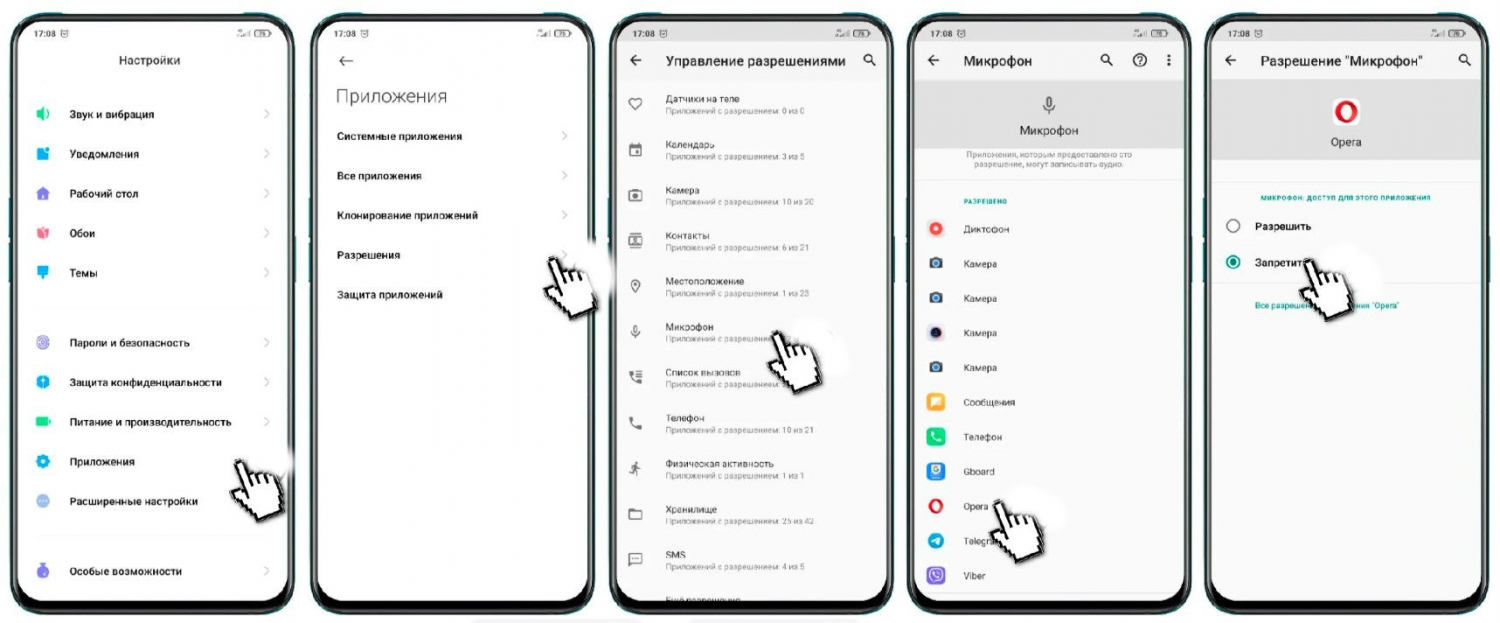

Заходите в «Настройки» —> Приложения —> Разрешения —> Разрешения —> Микрофон, и отключаете доступ к микрофону для тех приложений, в которых его использование кажется вам неуместным. Я например считаю что браузеру Opera микрофон без надобности, поэтому нажимаю на иконку и выставляю «Запретить»

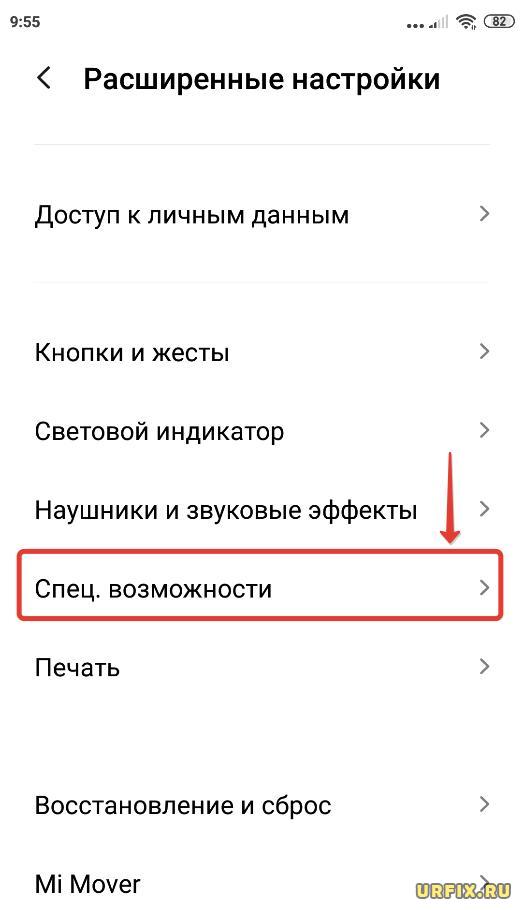

Отключаем сбор данных от Google

Теперь перейдём к отключению сбора данных, которые нежелательны не только потому, что информация об использовании передаётся непонятно куда без вашего ведома, но и по причине расхода (пусть и небольшого) мобильного интернета, а значит и заряда батареи.

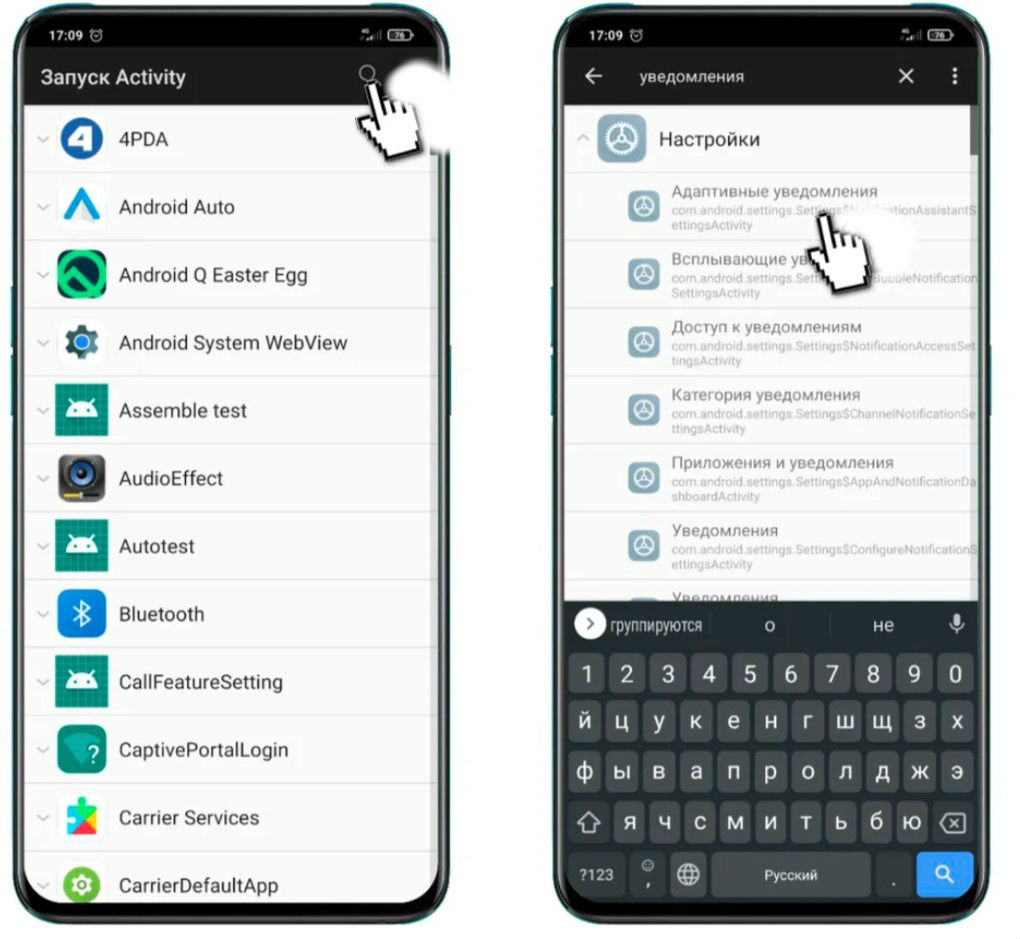

Для удобства будем использовать уже знакомый вам «Запуск Activity» (ссылка в конце). Итак, заходите в приложение, ожидаете окончание загрузки списка и пишете в поиске слово «уведомления».

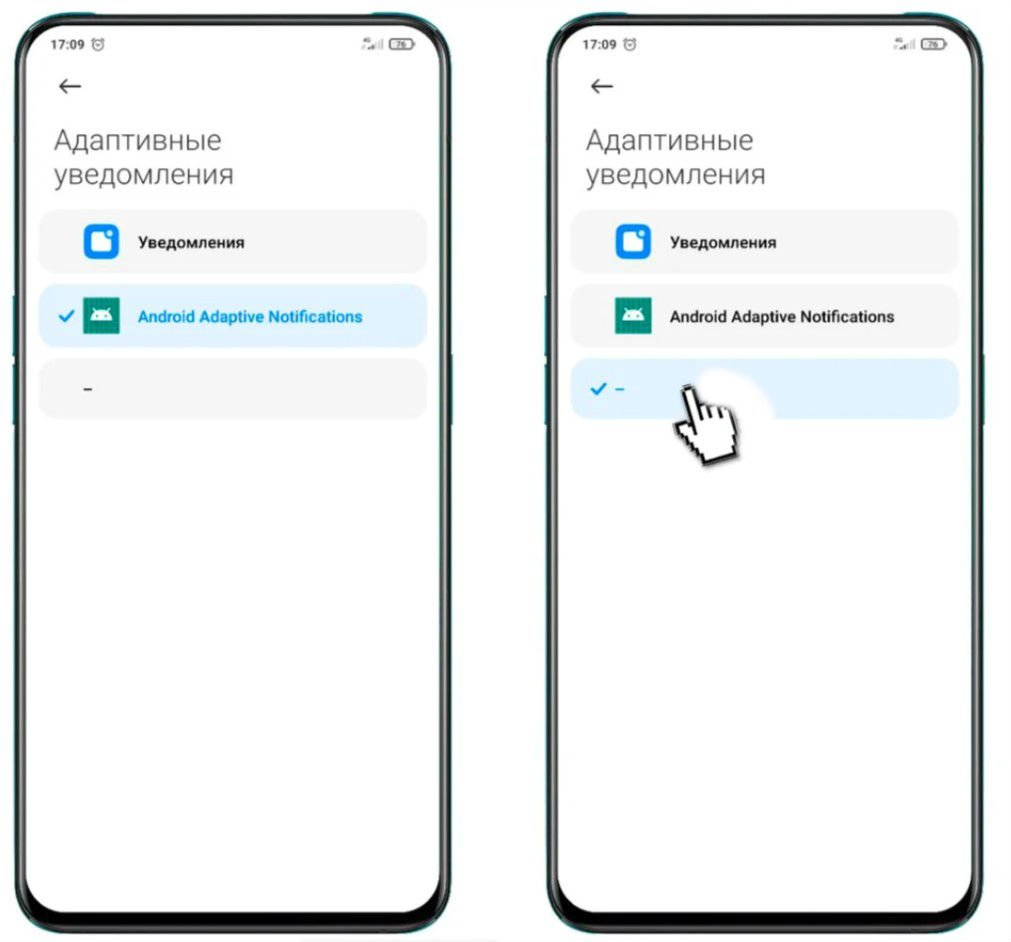

Заходите в пункт «Адаптивные уведомления» и видите что по умолчанию выбран пункт «Android Adaptive Notification», который я рекомендую отключить выбрав самую нижнюю строку.

Коротко объясню что это и как работает. В Android 10 появилась новая фишка уведомлений, благодаря которой, обучаясь, система понимает какие из уведомлений интересуют вас больше остальных и поэтому располагает их вверху списка.

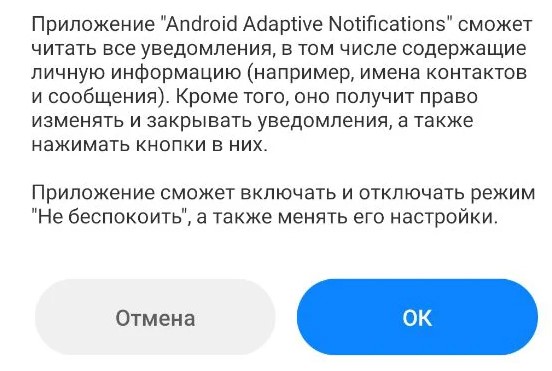

Однако, если вы, как и я не допускаете чтобы количество непрочитанных уведомлений переваливало за 5-7 штук, эта функция становится бесполезной, ведь впустую тратит ресурсы системы, обрабатывая данные, в чём вы можете убедиться прочитав информацию при повторном включении.

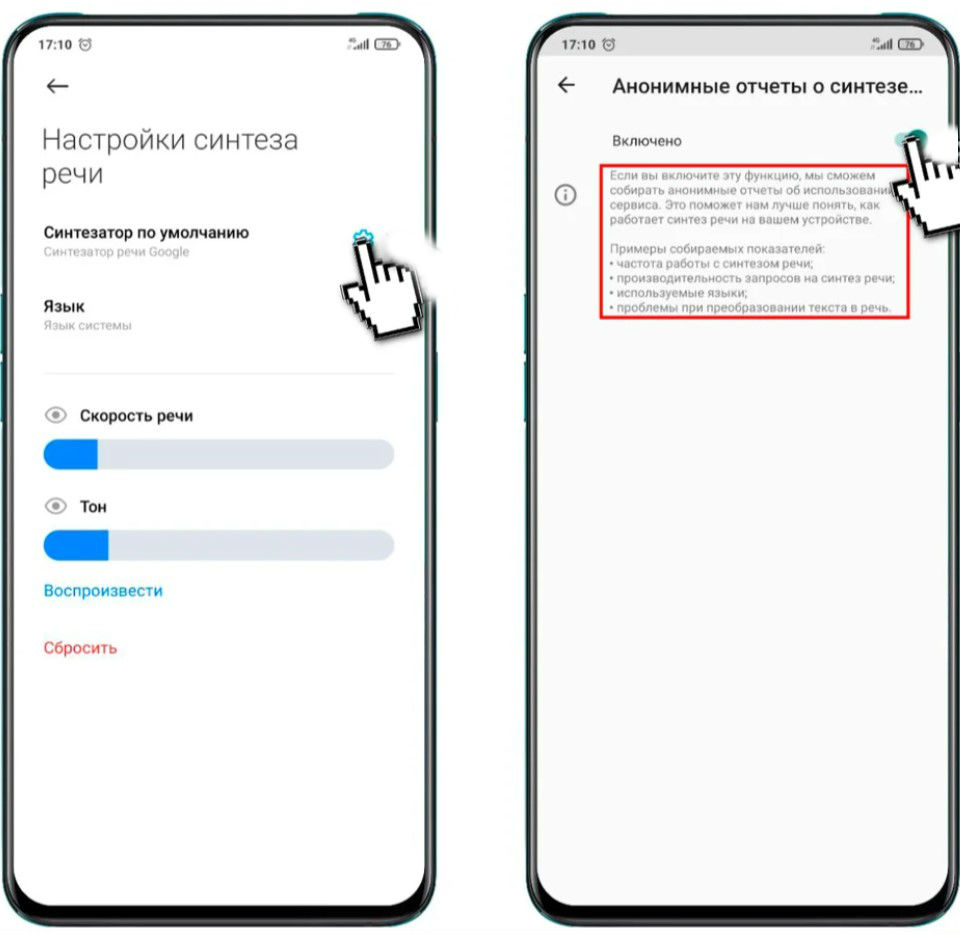

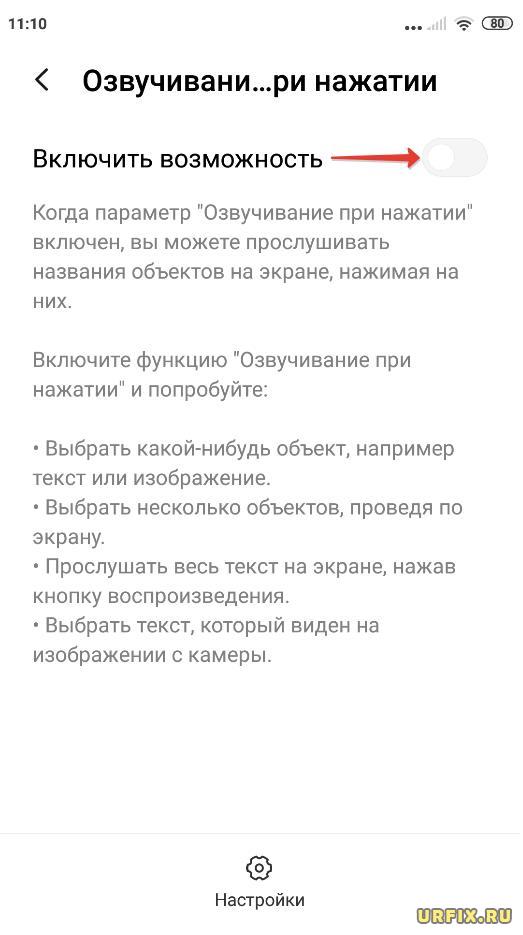

Далее нажимаете на значок шестерёнки и видите, что в строке «Анонимные отчёты о синтезе речи» выбрано «Включено». Заходите в этот пункт меню, читаете информацию о том, что сбор отчётов ведётся постоянно и выключаете сбор данных нажав на соответствующий переключатель.

На этом у меня на сегодня всё, статья про звук готова, осталось только протестировать всё на Redmi Note 8 Pro (из-за MTK процессора). Так что наберитесь терпения. Материал получился отличный (на мой взгляд).

Отключение синтезатора речи Google на Android телефоне

Автор: Юрий Белоусов · 25.09.2020

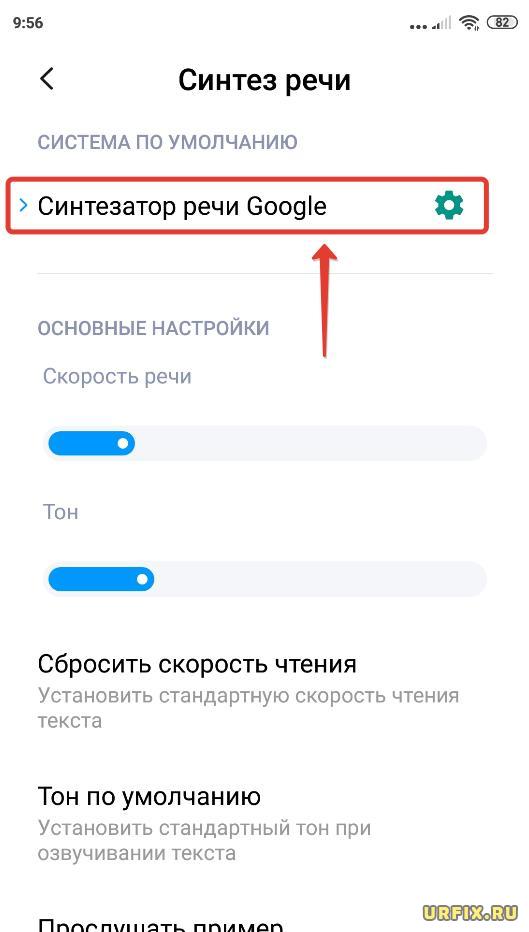

Синтезатор речи Google – предустановленное на многие устройства под управлением Android приложение, позволяющее озвучивать текст в других приложениях. Оно используется в приложениях для чтения книг, переводчиках, а также в TalkBack, которое озвучивает текст на экране, облегчая взаимодействие с устройством для людей с нарушением зрения.

В этой статье рассмотрим, как отключить синтезатор речи Google на Android телефоне или планшете.

Можно ли отключить синтез речи Google?

На текущий момент отключение синтеза речи Google на Android невозможно, такой функции не предусмотрено. Кроме того, данное приложение невозможно удалить с мобильного устройства, так как оно вшито в операционную систему.

Но можно установить другое приложение и тогда станет доступной возможность изменить голосовой синтезатор речи по умолчанию.

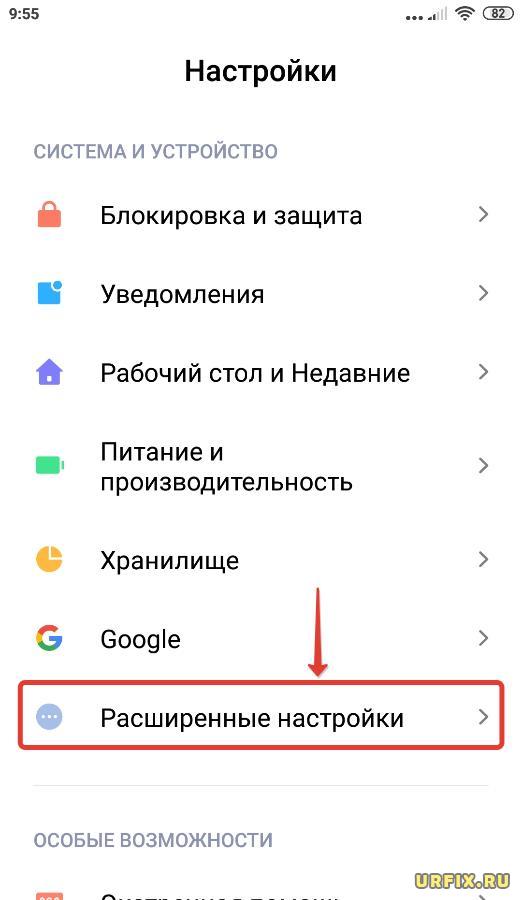

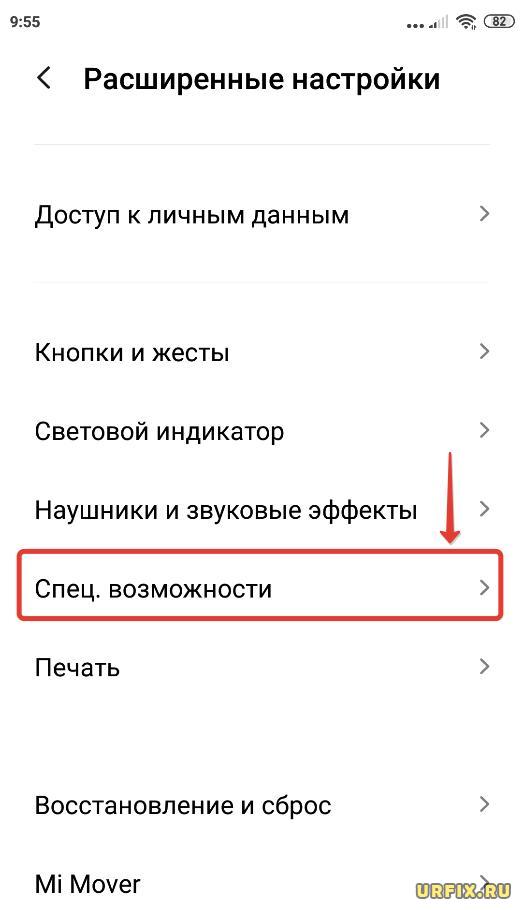

Произвести смену дефолтного синтезатора речи можно проделав следующую инструкцию:

Эта инструкция универсальная для всех устройств под управлением Android: Honor, Huawei, Vivo, Xiaomi и др.

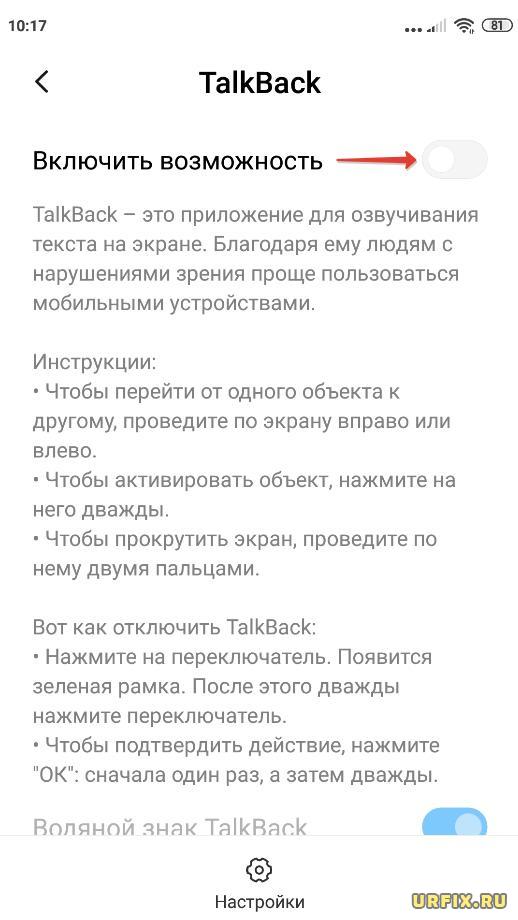

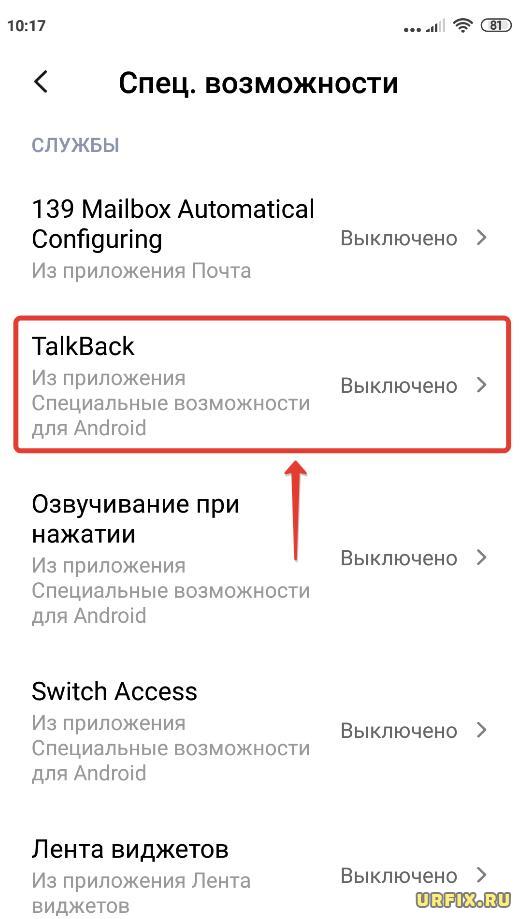

Как отключить TalkBack

В большинстве случаев, пользователь испытывает проблемы именно с приложением TalkBack, которое озвучивает все, что есть на экране устройства и ошибочно полагая, что виной всему речевой синтезатор Google. Но это не так.

Как выключить TalkBack:

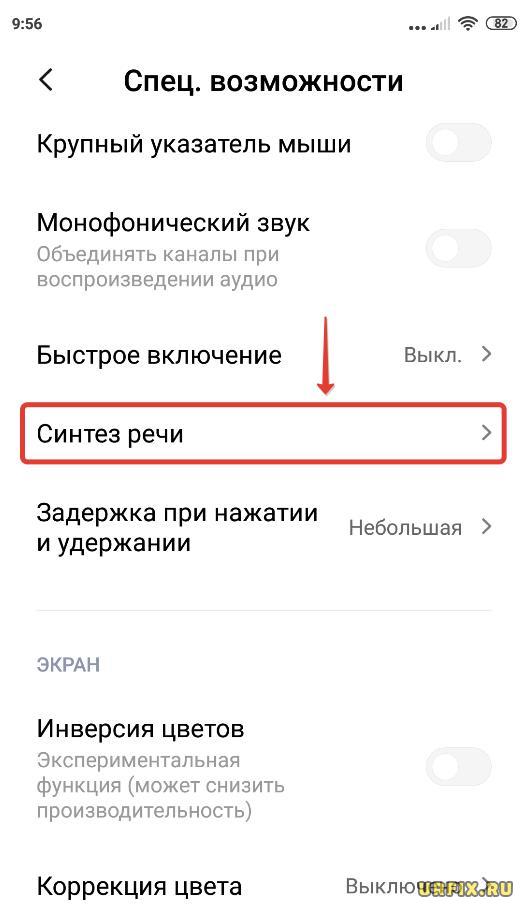

Как отключить озвучивание при нажатии Android

Еще одна функция, использующая синтезатор речи от Google, способная доставить неудобства – озвучивание при нажатии. Отключить ее можно, выполнив следующие несложные действия:

Не нашли ответ? Тогда воспользуйтесь формой поиска:

Распознавание и синтез речи: как ИИ анализирует наши разговоры

Технический прогресс привел к появлению машин, которые могут понимать, что говорит человек и, более того, в состоянии поддерживать диалог. Некоторые системы говорят так хорошо, что человек в первые пару минут общения с машиной может и не понять, кто его собеседник. Технологии распознавания и синтеза речи — не игрушка и не научный эксперимент. Это инструмент бизнеса, который внедряется все более активно.

Немного истории

Первое устройство, которое «понимало» речь человека, появилось в 1926 году. Это был робот Televox. В нем было три камертона, каждый реагировал на определенную тональность и включал одно из трех реле, отвечающих за разные функции. Но, конечно, это было не распознавание речи в современном понимании.

Ровно через полвека, в 1976 году была разработана полноценная система распознавания, которая понимала уже около 1000 слов. Но и это только отдельные слова, а не полноценный разговор.

https://youtu.be/32KKg3aP3Vw

Лишь в 1996 году появилась первая программа, способная различать непрерывную речь человека, а не команды. Создателем этой технологии стала компания IBM.

В 2016 году системы распознавания речи уже были достаточно широко распространены, хотя точность их работы не превышала 70-80%. То есть из 100 произнесенных слов от 20 до 30 машина не понимала. Сейчас точность некоторых систем превышает 90%, а это значит что, с такой программой можно вести полноценный разговор — она «поймет» текст, и более того, сможет оценить его эмоциональную окраску.

Достигнуть таких результатов удалось при помощи нейросетей — специализированных ИИ-систем, принцип работы которых похож на принцип работы мозга человека. Нейросети также умеют обучаться. Конечно, это не полноценный искусственный интеллект, но все же самообучающаяся система.

Как работает распознавание речи?

Нейросеть анализирует аудиопоток речи человека, разделяя его на отдельные фрагменты. Они называются фонемами. Каждый фрагмент анализируется путем сверки с базой эталонных звуков обученной нейросети и сопоставляется букве, слогу или целому слову. После многократного анализа фонем они расшифровываются в текст. Получившаяся текстовая запись затем снова сравнивается с базой слов нейросети. После выполнения всех действий нейросеть выдает готовый текст.

Чем дольше обучать систему, тем точнее она сможет различать отдельные фонемы, правильнее расшифровывая речь человека. Пол или возраст говорящего, кстати, не имеет особого значения. Для каждого языка приходится обучать отдельную нейросеть: так, система, научившись распознавать английский, не будет понимать французский.

Кроме речи, роботы уже способны распознавать и эмоции человека — по голосу или в тексте. Проще всего распознавать три базовые эмоции: позитивная, нейтральная, негативная — чем их больше, тем сложнее различать. Например, робот почти не видит разницу между обеспокоенностью и раздражением, поэтому вероятность ошибки высокая. Точность распознавания 3-х эмоций составляет около 93%.

В настоящее время уже довольно точно определяется пол человека по голосу — примерно со 2 секунды разговора робот практически на 100% знает, что общается с мужчиной или женщиной.

Как работает синтез речи?

Науке, бизнесу и медицине интересны роботы и машины, которые не просто озвучивают текстовые фрагменты, но и синтезируют собственные кусочки текста. С этим, хотя и не очень хорошо, справляются даже электронные книги. Речь идет о полноценном общении, когда человек что-то спрашивает у машины, та понимает и дает адекватный ответ. И здесь все еще сложнее, чем в случае с распознаванием речи.

В этом случае на сцену выходят нейросети. Для создания полноценной системы синтеза речи обычно требуется большая команда специалистов из разных областей, причем не только IT-экспертов, но и лингвистов, специалистов по фонетике, акустике, просодике и другим специальностям. Так, программа, которая синтезирует речь, должна уметь правильно расставлять ударения, различать слова-омографы вроде «замОк» и «зАмок», правильно расставлять и выдерживать паузы, корректно формировать интонацию и даже понимать эмоции. Все это очень сложно, особенно если учесть, что для разных языков нужны по-разному обученные системы.

Зачем нам распознавать или синтезировать речь?

Распознавание речи используется различными отраслями бизнеса, науки, медицины. Например, посредством этой технологии, люди с ограничениями здоровья могут управлять своим домом при помощи речи, или же надиктовывать тексты статей, электронных сообщений, sms. Также не стоит забывать и о голосовых помощниках, которые есть сейчас почти в каждом смартфоне, колонке вроде Алисы или ПК под управлением Windows и Mac.

Бизнесу распознавание речи тоже необходимо для разных целей, но одна из главных — это коммуникация с клиентами при помощи телефонных роботов, ботов. Это очень востребованная технология, которая позволяет сэкономить деньги, используя для выполнения рутинных задач машины, а не людей.

Как роботы (не) заменяют операторов колл-центров

Одно из направлений бизнеса, где есть потребность в голосовых роботах — колл-центры. К слову, объем рынка коммуникаций в одной только России оценивается в 150 млрд рублей, значительную часть этого рынка занимают колл-центры, их доля оценивается в 12-15 млрд. Роботов ставят на выполнение задач, которые можно без труда автоматизировать, а люди в это время выполняют более сложные, с которыми машины пока справиться не в состоянии.

Однако операторы колл-центров могут не переживать о том, что их работу отнимут голосовые боты. Как и сказано выше — просто потому, что у людей и роботов разные функции. Показательный пример — сотрудничество с колл-центром компании-партнера TWIN. Проект стартовал, когда в колл-центре работало 500 человек. Сейчас, спустя два года, в нем же работает уже 600 сотрудников. При этом также расширился и спектр задач, выполняемых голосовым роботом. Этот кейс может служить доказательством того, что в ближайшие 7-10 лет роботы окажут самое незначительное влияние на рынок труда операторов колл-центра.

Пример использования робота № 1. С 2016 кода TWIN активно сотрудничает с финтех-компаниями в России. Роботы помогают отвечать на однотипные вопросы, заданные клиентами. Кроме того, если возникает нестандартная ситуация, то робот способен оперативно переключить звонящего на оператора-человека. Например, мужчина заказал у транспортной компании вазу для своей жены на 8 марта. Ваза по какой-то причине не доставлена, и недовольный клиент звонит в компанию. Робот сразу же определяет эмоциональное состояние человека и не задает обычные вопросы, а переводит на оператора, который и решает возникшую проблему.

Пример использования робота № 2. Несколько лет назад в России появился проект робота-эйчара. Робота назвали «Вера», и работает она очень эффективно. Роботу дают задачу — например, найти IT-специалиста с определенными компетенциями. Вера сначала ищет походящих кандидатов на сайтах вроде hh.ru, собирает данные специалистов с нужными характеристиками, а затем начинает им звонить. Бот спрашивает, заинтересован ли соискатель в вакансии, и если тот отвечает положительно, то робот и человек назначают дату созвона с HR-менеджером. Если же ответ со стороны соискателя отрицательный, то робот просит прощения и кладет трубку.

И в первом, и во втором случае голосовые боты могут одновременно разговаривать с сотнями и тысячами абонентов. Это значительно превышает возможности оператора-человека и повышает эффективность компании. Но и задачи здесь, как видим, относительно простые, так что операторы-люди включаются в дело тогда, когда у робота возникает проблема.

В целом технологии как распознавания, так и синтеза речи совершенствуются, становятся все более функциональными. Отличить в простом диалоге по телефону робота от человека бывает крайне сложно. Вероятно, в недалеком будущем голосовые боты полностью возьмут на себя рутинные задачи колл-центров. Кроме того, сейчас активно развивается и направление электронных помощников — через лет пять они станут гораздо более функциональными, чем Siri, Алиса или Маруся. Роботы, способные понимать человеческую речь, различать эмоции и адекватно отрабатывать любые эмоциональные состояния человека, сделают жизнь людей проще, а бизнес — эффективнее.

MIUI 12 и MIUI 11: Запрещаем Google собирать данные

Да, действительно, подобная проблема со временем может появиться, а один из возможных вариантов её решения прост и не требует сбросов и сложных манипуляций.

Заходите в «Настройки» —> Приложения —> Разрешения —> Разрешения —> Микрофон, и отключаете доступ к микрофону для тех приложений, в которых его использование кажется вам неуместным. Я например считаю что браузеру Opera микрофон без надобности, поэтому нажимаю на иконку и выставляю «Запретить»

Отключаем сбор данных от Google

Теперь перейдём к отключению сбора данных, которые нежелательны не только потому, что информация об использовании передаётся непонятно куда без вашего ведома, но и по причине расхода (пусть и небольшого) мобильного интернета, а значит и заряда батареи.

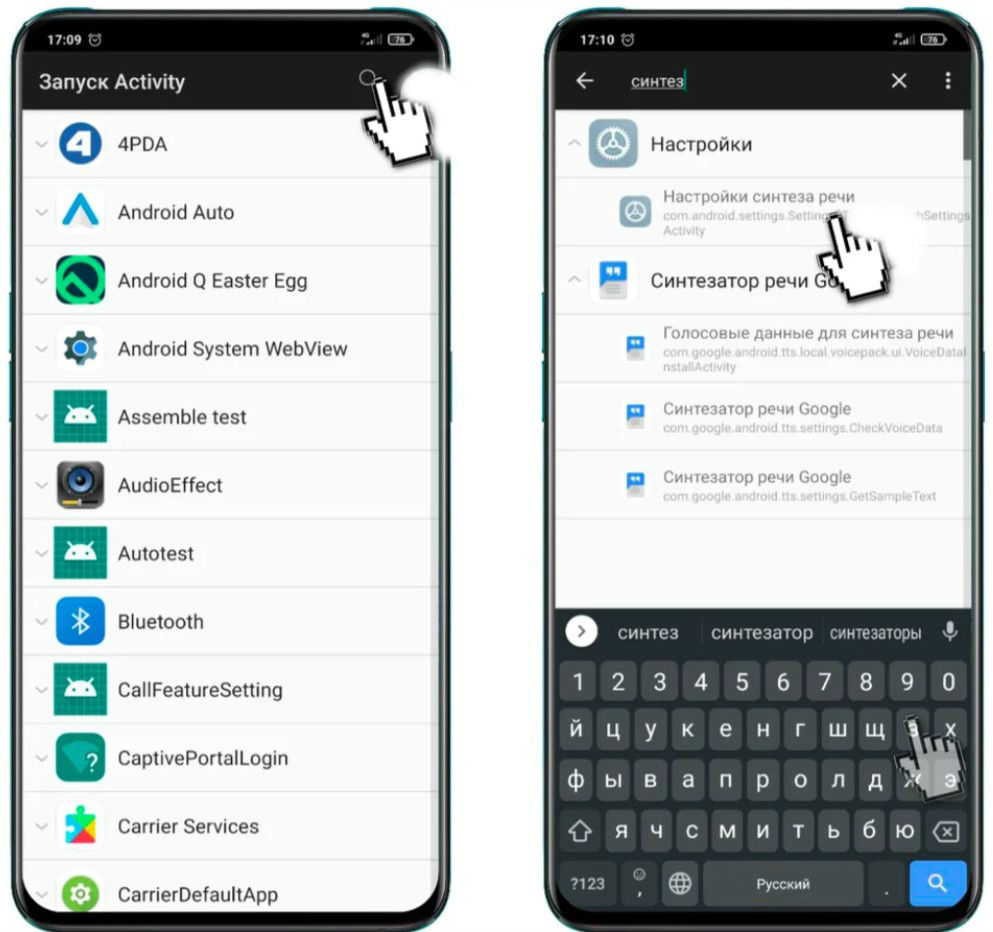

Для удобства будем использовать уже знакомый вам «Запуск Activity» (ссылка в конце). Итак, заходите в приложение, ожидаете окончание загрузки списка и пишете в поиске слово «уведомления».

Заходите в пункт «Адаптивные уведомления» и видите что по умолчанию выбран пункт «Android Adaptive Notification», который я рекомендую отключить выбрав самую нижнюю строку.

Коротко объясню что это и как работает. В Android 10 появилась новая фишка уведомлений, благодаря которой, обучаясь, система понимает какие из уведомлений интересуют вас больше остальных и поэтому располагает их вверху списка.

Однако, если вы, как и я не допускаете чтобы количество непрочитанных уведомлений переваливало за 5-7 штук, эта функция становится бесполезной, ведь впустую тратит ресурсы системы, обрабатывая данные, в чём вы можете убедиться прочитав информацию при повторном включении.

Решать конечно вам, но лично я отключил адаптивные уведомления системы Android и не заметил абсолютно никаких проблем в работе смартфона.

Теперь отключим ещё одну бесполезную функцию от Google, которая активна практически на всех смартфонах. Опять же запускаете «Запуск Activity» —> в поиске пишите «синтез» —> выбираете «Настройка синтеза речи»

Далее нажимаете на значок шестерёнки и видите, что в строке «Анонимные отчёты о синтезе речи» выбрано «Включено». Заходите в этот пункт меню, читаете информацию о том, что сбор отчётов ведётся постоянно и выключаете сбор данных нажав на соответствующий переключатель.

На этом у меня на сегодня всё, статья про звук готова, осталось только протестировать всё на Redmi Note 8 Pro (из-за MTK процессора). Так что наберитесь терпения. Материал получился отличный (на мой взгляд).

Обзор технологий синтеза речи

Всем привет! Меня зовут Влад и я работаю data scientist-ом в команде речевых технологий Тинькофф, которые используются в нашем голосовом помощнике Олеге.

В этой статье я бы хотел сделать небольшой обзор технологий синтеза речи, использующихся в индустрии, и поделиться опытом нашей команды построения собственного движка синтеза.

Синтез речи

Синтез речи — это создание звука на основе текста. Эту задачу сегодня решают двумя подходами:

Речь моделей unit selection имеет высокое качество, низкую вариативность и требует большого объема данных для обучения. В то же время для тренировки параметрических моделей необходимо гораздо меньшее количество данных, они генерируют более разнообразные интонации, но до недавнего времени страдали от общего достаточно низкого качества звука по сравнению с подходом unit selection.

Однако с развитием технологий глубокого обучения модели параметрического синтеза достигли существенного прироста по всем метрикам качества и способны создавать речь, практически неотличимую от человеческой.

Метрики качества

Прежде чем говорить о том, какие модели синтеза речи лучше, нужно определить метрики качества, по которым будет проводиться сравнение алгоритмов.

Поскольку один и тот же текст можно прочитать бесконечным количеством способов, априори правильного способа для произношения конкретной фразы не существует. Поэтому зачастую метрики качества синтеза речи субъективны и зависят от восприятия слушающего.

Стандартная метрика — это MOS (mean opinion score), усредненная оценка естественности речи, выданная асессорами для синтезированных аудио по шкале от 1 до 5. Единица означает совсем неправдоподобное звучание, а пятерка — речь, неотличимую от человеческой. Реальные записи людей обычно получают значения примерно 4,5, и значение больше 4 считается достаточно высоким.

Как работает синтез речи

Первый шаг к построению любой системы синтеза речи — сбор данных для обучения. Обычно это аудиозаписи высокого качества, на которых диктор читает специально подобранные фразы. Примерный размер датасета, необходимый для обучения моделей unit selection, составляет 10—20 часов чистой речи [2], в то время как для нейросетевых параметрических методов верхняя оценка равна примерно 25 часам [4, 5].

Обсудим обе технологии синтеза.

Unit selection

Обычно записанная речь диктора не может покрыть всех возможных случаев, в которых будет использоваться синтез. Поэтому суть метода состоит в разбиении всей аудиобазы на небольшие фрагменты, называющиеся юнитами, которые затем склеиваются друг с другом с использованием минимальной постобработки. В качестве юнитов обычно выступают минимальные акустические единицы языка, такие как полуфоны или дифоны [2].

Весь процесс генерации состоит из двух этапов: NLP frontend, отвечающий за извлечение лингвистического представления текста, и backend, который вычисляет функцию штрафа юнитов для заданных лингвистических признаков. В NLP frontend входят:

Обычно NLP frontend реализован с помощью вручную прописанных правил для конкретного языка, однако в последнее время происходит все больший уклон в сторону использования моделей машинного обучения [7].

Штраф, оцениваемый backend-подсистемой, — это сумма target cost, или соответствия акустического представления юнита для конкретной фонемы, и concatenation cost, то есть уместности соединения двух соседних юнитов. Для оценки штраф функций можно использовать правила или уже обученную акустическую модель параметрического синтеза [2]. Выбор наиболее оптимальной последовательности юнитов с точки зрения выше определенных штрафов происходит с помощью алгоритма Витерби [1].

Примерные значения MOS моделей unit selection для английского языка: 3,7—4,1 [2, 4, 5].

Достоинства подхода unit selection:

Параметрический синтез речи

В основе параметрического подхода лежит идея о построении вероятностной модели, оценивающей распределение акустических признаков заданного текста.

Процесс генерации речи в параметрическом синтезе можно разделить на четыре этапа:

Для обучения duration и акустической моделей можно использовать скрытые марковские модели [3], глубокие нейронные сети или их рекуррентные разновидности [6]. Традиционный вокодер — это алгоритм, основанный на source-filter модели [3], которая предполагает, что речь — это результат применения линейного фильтра шума к первоначальному сигналу.

Общее качество речи классических параметрических методов оказывается достаточно низким из-за большого количества независимых предположений об устройстве процесса генерации звука.

Однако с приходом технологий глубокого обучения стало возможным обучать end-to-end модели, которые напрямую предсказывают акустические признаки по буквам. Например, нейронные сети Tacotron [4] и Tacotron 2 [5] принимают на вход последовательность букв и возвращают мел-спектрограмму с помощью алгоритма seq2seq [8]. Таким образом шаги 1—3 классического подхода заменяются одной нейросетью. На схеме ниже показана архитектура сети Tacotron 2, достигающей достаточно высокого качества звука.

Другим фактором существенного прироста в качестве синтезируемой речи стало применение нейросетевых вокодеров вместо алгоритмов цифровой обработки сигналов.

Первым таким вокодером была нейронная сеть WaveNet [9], которая последовательно, шаг за шагом, предсказывала значения амплитуды звуковой волны.

Благодаря использованию большого количества сверточных слоев с пропусками для захвата большего контекста и skip connection в архитектуре сети удалось достичь примерно 10%-го улучшения MOS по сравнению с моделями unit selection. На схеме ниже представлена архитектура сети WaveNet.

Главный недостаток WaveNet — низкая скорость работы, связанная с последовательной схемой сэмплирования сигнала. Эту проблему можно решить либо с помощью инженерной оптимизации для конкретной архитектуры железа, либо заменой схемы сэмплирования на более быструю.

Оба подхода были успешно реализованы в индустрии. Первый — в Tinkoff.ru, а в рамках второго подхода компания Google представила сеть Parallel WaveNet [10] в 2017 году, наработки которой используются в Google Assistant.

Примерные значения MOS для нейросетевых методов: 4,4—4,5 [5, 11], то есть синтезируемая речь практически не отличается от человеческой.

Достоинства параметрического синтеза:

Как работает синтез речи в Tinkoff

Как следует из обзора, методы параметрического синтеза речи, основанные на нейросетях, на текущий момент существенно превосходят по качеству подход unit selection и гораздо проще для разработки. Поэтому для построения собственного движка синтеза мы использовали именно их.

Для обучения моделей было использовано около 25 часов чистой речи профессионального диктора. Тексты для чтения были специально подобраны так, чтобы наиболее полно покрыть фонетику разговорной речи. Кроме того, чтобы добавить синтезу большее разнообразие в интонации, мы попросили диктора читать тексты с выражением, зависящим от контекста.

Архитектура нашего решения концептуально выглядит так:

Благодаря такой архитектуре наш движок генерирует выразительную речь высокого качества в режиме реального времени, не требует построения фонемного словаря и дает возможность управлять ударениями в отдельных словах. Примеры синтезированных аудио можно прослушать, перейдя по ссылке.

Ссылки:

[1] A. J. Hunt, A. W. Black. Unit selection in a concatenative speech synthesis system using a large speech database, ICASSP, 1996.

[2] T. Capes, P. Coles, A. Conkie, L. Golipour, A. Hadjitarkhani, Q. Hu, N. Huddleston, M. Hunt, J. Li, M. Neeracher, K. Prahallad, T. Raitio, R. Rasipuram, G. Townsend, B. Williamson, D. Winarsky, Z. Wu, H. Zhang. Siri On-Device Deep Learning-Guided Unit Selection Text-to-Speech System, Interspeech, 2017.

[3] H. Zen, K. Tokuda, A. W. Black. Statistical parametric speech synthesis, Speech Communication, Vol. 51, no. 11, pp. 1039-1064, 2009.

[4] Yuxuan Wang, RJ Skerry-Ryan, Daisy Stanton, Yonghui Wu, Ron J. Weiss, Navdeep Jaitly, Zongheng Yang, Ying Xiao, Zhifeng Chen, Samy Bengio, Quoc Le, Yannis Agiomyrgiannakis, Rob Clark, Rif A. Saurous. Tacotron: Towards End-to-End Speech Synthesis.

[5] Jonathan Shen, Ruoming Pang, Ron J. Weiss, Mike Schuster, Navdeep Jaitly, Zongheng Yang, Zhifeng Chen, Yu Zhang, Yuxuan Wang, RJ Skerry-Ryan, Rif A. Saurous, Yannis Agiomyrgiannakis, Yonghui Wu. Natural TTS Synthesis by Conditioning WaveNet on Mel Spectrogram Predictions.

[6] Heiga Zen, Andrew Senior, Mike Schuster. Statistical parametric speech synthesis using deep neural networks.

[7] Hao Zhang, Richard Sproat, Axel H. Ng, Felix Stahlberg, Xiaochang Peng, Kyle Gorman, Brian Roark. Neural Models of Text Normalization for Speech Applications.

[8] Ilya Sutskever, Oriol Vinyals, Quoc V. Le. Sequence to Sequence Learning with Neural Networks.

[9] Aaron van den Oord, Sander Dieleman, Heiga Zen, Karen Simonyan, Oriol Vinyals, Alex Graves, Nal Kalchbrenner, Andrew Senior, Koray Kavukcuoglu. WaveNet: A Generative Model for Raw Audio.

[10] Aaron van den Oord, Yazhe Li, Igor Babuschkin, Karen Simonyan, Oriol Vinyals, Koray Kavukcuoglu, George van den Driessche, Edward Lockhart, Luis C. Cobo, Florian Stimberg, Norman Casagrande, Dominik Grewe, Seb Noury, Sander Dieleman, Erich Elsen, Nal Kalchbrenner, Heiga Zen, Alex Graves, Helen King, Tom Walters, Dan Belov, Demis Hassabis. Parallel WaveNet: Fast High-Fidelity Speech Synthesis.

[11] Wei Ping Kainan Peng Jitong Chen. ClariNet: Parallel Wave Generation in End-to-End Text-to-Speech.

[12] Dario Rethage, Jordi Pons, Xavier Serra. A Wavenet for Speech Denoising.