что такое esxi и proxmox

Proxmox vs ESXi

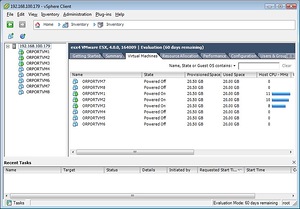

What’s the best virtualization solution for your homelab? The other day a friend asked me this. I replied with two options: VMware ESXi or Proxmox VE.

What is a hypervisor? In case you’ve been in the dark for the last decade, a hypervisor is a server that allows you to run multiple virtual machines (VMs) on physical hardware. VMs are useful for isolation (good for security and also for learning since you can wipe out and recreate VMs at will). But virtualization is also an essential foundation for any sort of IT infrastructure, including a homelab. A virtual environment gives you the flexibility to install and run almost anything down the road, even if you can’t foresee it today.

VMware ESXi or Proxmox VE

Two popular Hypervisor options are VMware ESXi and Proxmox VE. These are both Virtualization platforms and allow for running many VMs or containers at high density. Both perform well (I have not done formal testing, but I can’t tell the difference in CPU performance).

VMware is the king of virtualization. You will not find many companies not using VMware until you get to large corporations where open source solutions based on Xen or KVM take over. But anywhere in between from small to medium businesses, you will find VMware everywhere. Also, if you will use any other enterprise-class solution, be it a SIEM, storage, monitoring tool, etc. the vendor will most likely support running on VMware or have integration with it if applicable.

While VMware is proprietary, it is robust and fully featured. ESXi’s vSAN and distributed switching, high availability, and fault-tolerance are unparalleled.

VMware ESXi free is the hypervisor of choice for many homelabs, and VMUG Advantage ($200/year) allows you to use all the features (with up to 6 CPUs) in a non-production environment for no cost.

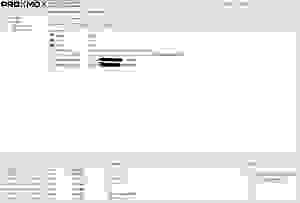

Another option I like is Proxmox VE. In fact, I like it better than VMware ESXi.

Over the last 16 months, I have migrated most of my VMware VMs over to Proxmox in my Homelab. But I don’t recommend this switch to everyone. If you are learning virtualization to work in an enterprise environment, you want to stick with VMware. Why? I know of hundreds of businesses that use VMware. I know of 1 using Proxmox.

Why Did I Switch to Proxmox VE? Ansible Integration

Migrating from VMware to Proxmox

My Thoughts on Proxmox

Proxmox is excellent. You get Clustering, Live-migration, High Availability. All for free. You can use ZFS on a single box without the complexity of running FreeNAS on VMware All-in-One. If you have two Proxmox servers, they can use ZFS to mirror each other. With three or more Proxmox servers (technically you only need two with a Raspberry Pi to maintain the quorum), Proxmox can configure a Ceph cluster for distributed, scalable, and high-available storage. From one small server to a cluster, Proxmox can handle a variety of scenarios.

Proxmox builds on open-source technology. KVM for VMs, LXC for Containers, ZFS or Ceph for storage, and bridged networking or Open vSwitch for networking. You could run the open-source components in an ad hoc manner yourself (before I tried Proxmox I had experimented with an Ubuntu LXD server), but Proxmox provides a nice single pane of glass. Besides the GUI, it adds some features like live-migration and integrated backups and alerts on failures or warnings.

My favorite feature in Proxmox that VMware doesn’t have is containers! These aren’t docker containers, but full system containers. Containers allow you to get a higher density (in terms of memory) than VMs because containers share the host kernel. Ubuntu reports a 14.5 higher density using containers instead of VMs. I love the way containers work. You can download whatever templates you want (they include all popular Linux distributions) and then instantly deploy containers from those templates.

Getting performance information on the cluster, individual nodes, VMs, or containers is simple. At a glance, you can see where your bottleneck is and see which VMs and containers are consuming what resources.

Why I would choose VMware ESXi or Proxmox VE

Reasons to use VMware ESXi

Reasons to use Proxmox VE

VMware ESXi and Proxmox VE feature comparison Chart

| Hypervisor | VMware ESXi Free | VMware ESXi VMUG | Proxmox VE CE | Proxmox VE Enterprise |

| Cost | Free | $200/year | Free | $85/year/CPU |

| Max CPUs | ∞ | 6 | ∞ | ∞ |

| Clustering | No | Yes | Yes | Yes |

| HA-Failover | No | Yes | Yes | Yes |

| HA-Storage | No | Yes, vSAN | Yes, Ceph | Yes, Ceph |

| Fault Tolerance | No | Yes | No | No |

| VMs | Yes | Yes | Yes | Yes |

| Containers | No | Yes | Yes | Yes |

| Live-Migration | No | Yes | VMs only | VMs only |

| VM Backups | 3rd Party: Veeam | 3rd Party: Veeam | Yes | Yes |

| GUI for Virtual Networking | Yes | Yes | No | No |

| Distributed vSwitch | Yes | Yes | No | No |

| Management | No | Yes | Yes | Yes |

| Storage Compatible | iSCSI, NFS, FC, FCoE, local | iSCSI, NFS, vSAN, FC, FCoE, SAN | iSCSI, NFS, ZFS, Ceph, CIFS, GlusterFS | iSCSI, NFS ZFS, Ceph, CIFS, GlusterFS |

| Enterprise SAN integration | N/A | Yes | No | No |

| Minimum Nodes for HA | N/A | 2 (3 preferred) | 3 (or 2 + witness device) | 3 (or 2 + witness device) |

| Per VM Firewall | No | No | Yes | Yes |

| License allows renting out VMs/Containers | No | VSPP Required | Yes | Yes |

| License allows business use | Yes | No | Yes | Yes |

| Code License | Proprietary | Proprietary | AGPLv3 | AGPLv3 |

| API (Integration with Ansible, etc.) | No | Yes | Yes | Yes |

Alternatives to ESXi and Proxmox VE

If you enjoy doing everything off the CLI, you can just use KVM for VMs and LXD for containers. I prefer to have some sort of management system. I find it helpful because it automatically does a lot of things for me like running backups, alerting on the system or drive failures, and monitoring performance. oVirt may be a good option, I passed it by because the list of supported operating systems is outdated so I don’t know how well maintained the project is. Bhyve is another option based on FreeBSD; however, last I tested, it wasn’t entirely stable and resulted in a few crashes under load. I tried to get Hyper-V up and running once, but it wanted to be in an Active Directory environment, and I didn’t want to hack it to work standalone. Xenserver is another option, but it has been discontinued. I do think the best options for homelab use are VMware and Proxmox. Of course, there’s also Kubernetes, but that’s for another post.

The Best Hypervisor for Your Goals

If your goal is to learn hypervisors or enterprise solutions that integrate with VMware for your career, the best hypervisor to learn is VMware ESXi. You cannot match the robustness and ubiquitousness of VMware. Otherwise, for homelab use, I prefer Proxmox. For a zero dollar budget, it offers a lot more freedom and features in the community edition than the ESXi free version.

Cost and licensing restrictions side, from a technical and feature perspective; I would rank the solutions as follows: ESXi VMUG > Proxmox VE Enterprise > Proxmox VE CE > ESXi Free.

One area that Proxmox excels is for those running a single box without hardware RAID. VMware ESXi free provides no software storage solution for a single hypervisor. Proxmox has built-in ZFS making for a much simpler design than the VMware and FreeNAS All-in-one.

My current homelab setup: I have Proxmox VE installed on two of my Supermicro servers. All of the VMs and containers are running there. And both Proxmox servers are backing up to my VMware+FreeNAS all-in-one box.

Which hypervisor do you use in your homelab, and why?

Бесплатная виртуализация — практическая применимость

VMWare vSphere (ESXi)

О продукции VMWare всегда был только лучшего мнения и эта платформа стала любимой, но при одном условии — соответствие HCL (hardware compatibility list). То есть если «железо» хоста не отвечает HCL то можно только надеяться, что сами контроллеры совпадут с теми, что используются в комплектующих из HCL и в vSphere окажутся драйвера для них. Если же нет, то не видать вам этой платформы на хосте. Это есть главный минус платформы, который вытекает из главного плюса — она законченная. То есть не надо ничего пилить, строгать и бегать с бубном. Если она встает — значит она встает. То есть с полпинка и готовая для использования в производственной среде. Может устанавливаться на флеш накопитель, подключает почти все возможные системы хранения (local, NFS, iSCSI, FC).

Правильный аппаратный RAID понимает без проблем, «неправильный» не понимает в принципе. Очень мощные функции управления виртуальными сетевыми адаптерами. Не знаю что уж там в платном виртуальном коммутаторе Nexus 1000, но бесплатный — вполне L2 switch. В частности мою основную и вспомогательную сетевые потребности отрабатывает на ура, а именно:

1) основная — это сетевой мост (вроде бы так называется этот функционал), то есть позволить выделенному виртуальному интерфейсу работать так, как будто к нему напрямую подключен провод. Не знаю как лучше это объяснить, по сути вполне ожидаемая функция, например так работает шлюз, ему отдан интерфейс с подключением к провайдеру, виртуальному интерфейсу средствами vSphere присвоен зарегестрированный MAC и шлюз по этому MAC’у получает у провайдера IP, устанавливает PPPoE канал и все тому подобное.

2) вспомогательная — L2 свитч с поддержкой tagged и untagged портов. Благодаря этому шлюз прекрасно маршрутизирует VLAN сети, будучи подключенным только к одному физическому интерфейсу.

Ну и на десерт — полноценный проброс USB устройств в гостевые системы (например аппаратных USB ключей) и неплохие бесплатные решения для миграции и резервных копий. Veeam Backup&Replicate в бесплатной редакции реализует даже hot storage vMotion. Родная утилита конвертации позволяет легко и просто переделывать образы физических машин и иных виртуальных машин в работающие образы vSphere. Если к этому еще добавить платный, но прелестный vmware workstation, который будучи очень хорошим гипервизором второго уровня умеет подключаться к хосту vSphere и управлять его виртуальными системами, то картина вырисовывается прямо загляденье. Расплаты тут только две увидел на данный момент: HCL и RAID.

Microsoft Hyper-V Server

Итак, что у нас в сухом остатке? Всеядность в отношении «железа» и всеядность в отношении RAID. Плюс должны работать качественные утилиты Veeam, но проверить я этого не смог — быстро решил искать ей замену.

Еще одна хваленая платформа. Почитал про её возможности и не смог устоять перед желанием испытать её, тем более что нужна была всеядная замена Hyper-V. И вот тут я понял, что это просто инвертированная vSphere во всех смыслах. Первое, с чем я столкнулся — множество разных вариантов разворачивания этой платформы. То есть предполагается, что человек должен все их попробовать, проанализировать и сделать вывод как правильнее в его случае. Как-то это непривычно в применении к серверам. К тому же не нашел официальных best practices по установке — реально кто во что горазд. Один утверждает, что надо все вручную сделать через libvirt, другой — что достаточно поставить VirtManager, а дальше все сделается автоматом, третий же утверждает, что лучше накатить ProxMox на Debian. Итог: желание попробовать вылилось в изучение доступных средств разворачивания и выбор оптимального. Таковыми являются на мой взгляд bare metal вариации, которые не требует предварительно установленной и подготовленной системы — пакет должен быть подогнан, так сказать «костюмчик должен сидеть». И из всего выходило, что внимания заслуживают дистрибутивы ProxMox и OpenNode. Первый на Debian, знакомство с которым старо и поверхностно, второй же на CentOS, который я использую не в одном экземпляре, считаю синонимом стабильности и конечно наследником RedHat way, с которого я и начинал знакомство с Linux.

OpenNode

OpenNode насчитывал уже 6-ую версию релиза и посему был воспринят мной, как серьезная заявка на платформу для производственной среды и уж тем более для дома. Установка преподнесла сюрприз — я никак не мог пройти этап первоначальной настройки сетевого интерфейса: вбиваю все настройки, потом инсталлятор пытается их применить и выдает ошибку, которую я уже и не помню. После множества вариантов настроек я сунул кабель в интерфейс и … вот она — причина. Почти как в Hyper-V инсталлятор не пускает вас дальше в настройке сетевого интерфейса, пока вы не дадите ему активный линк. Эх забыты времена, когда RedHat устанавливался с трех дисков на компьютер, вокруг которого в радиусе 2-х километров нигде не было интернета и сети. Ладно, с этим смирились, систему поставили, запустили консольный UI, который при создании хранилища вывалился с ошибкой. Ладно, посмотрим GUI, который представляет собой VirtualManager на сервере без иксов. Необычно, но решение оказывается есть и даже под Windows. Скачиваем и устанавливаем Xming(порт X-сервера), коннектимся по SSH и запускаем VirtualManager, который стартует в нашем порте X-ов. Несмотря на то, что я обычно не обращаю внимание на прорисованность интерфейсов серьезных продуктов, но даже этот я отметил словом «Убогий», а ведь на дворе все же 2013 год (дело происходило еще в 2013ом). Ладно и на это мои глаза спокойно закрываются, создаем виртуальную машину в стандартном хранилище (потому что другое не создается и вываливается с ошибкой) и на каком-то моменте VirtualManager вываливается с ошибкой и больше не стартует. Перезагрузка ему не помогает. Я думаю существуют всякие мануалы, как вручную допилить libvirt, найти в логах по коду ошибки причину, по которой VirtualManager не работает, исправить это в конфигах и заставить работать… я думаю можно, но желания уже нет.

ProxMox

6-ой релиз OpenNode не произвел должного впечатления. Остается последняя надежда — ProxMox, Неужели в этом мире с моими хотелками есть только vSphere — тогда они смело могут считать себя монополистами. Ставлю ProxMox, этап с настройкой интерфейса не проверил, так как линк уже был, установка прошла без проблем. Немного пришлось помучиться с перенастройкой сетевых интерфейсов — сказалось видимо плохое знание Debian. Первое отличие, которое бросается в глаза — тут используется не VirtualManager, а web panel. Это меня даже радует, потому что управление через веб я начинаю любить все больше. Конфигурация сетевых интерфейсов немного замудреная, но можно разобраться даже интуитивно. Почему то переконфигурация не давала эффекта без перезагрузки. Минус, но пока терпимый. В консоль для его исправления не лез по 2-м причинам: 1) Debian все равно мне плохо знаком 2) Рассматриваю продукт, а в нем все управление сосредоточено в панели управления, все что в консоли — скажем так «недокументированные возможности». Кроме того без «недокументированных возможностей» нет и поддержки сетей в VLAN. Наконец создаю виртуальную машину, образ для установки есть возможность загрузить прямо через вебморду, что вызывает восхищение после Hyper-V и OpenNode (в любимом vSphere это конечно же есть). MAC адреса виртуальным адаптерам присваиваются, подключение к ISP пробросил в виртуалку, приступаю к установке и… Java RE более старой версии ничего не позволяет сделать, на игноры предупреждения безопасности вылазит только окно Error. Придется обновить. Обновился, подключился к консоли, но через неделю эта версия Java не позволила мне снова подключится, потому что вышла новая версия. Мой сетевой тест #1 не вызвал проблем. Базовые функции по управлению виртуальными машинами вполне годные, функционал для альтернативы vSphere на этом рынке неплох, возможности по изменению «железа» VM, способы виртуализации KVM и openVZ(контейнеры). Статистики, бэкапы, снэпшоты, поддержка авторизации LDAP/AD, встроенные базы, подключение хранилищ: RBD, iSCSI, NFS и другие, которые у меня не на слуху, обновление и как я понял готовые скачиваемые пакеты openvz virtual appliances. А теперь на минутку вспомним, что это надстройка над Debian и тогда станет понятно, что если подключить сюда «поллитру» и бубен, то становятся возможными установка на неправильные raid и даже soft raid, доставка рабочего стола Spice (еще не попробовал, рассказать не могу), проброс USB устройств с хоста (к сожалению адрес пробрасываемого устройства меняется после перезагрузки), проброс PCI плат — а тут меня ждал облом — процессор не поддерживает passthrough. Как видите возможностей много, а с допилкой еще больше. Но разбираться с тем, что из этого заработает, а что нет только вам. Этакий конструктор, с неплохим стартовым набором и возможностью допиливания.

Наконец мой рейтинг таков:

1: VMWare vSphere

2: Top Mix: ProxMox

3: Hyper-V

Outsider: OpenNode.

Магия виртуализации: вводный курс в Proxmox VE

Сегодня речь пойдет о том, как быстро и достаточно просто на одном физическом сервере развернуть несколько виртуальных серверов с разными операционными системами. Любому системному администратору это позволит централизованно управлять всей IT-инфраструктурой компании и экономить огромное количество ресурсов. Использование виртуализации помогает максимально абстрагироваться от физического серверного оборудования, защитить критичные сервисы и легко восстановить их работу даже в случае очень серьезных сбоев.

Без всякого сомнения, большинству системных администраторов знакомы приемы работы с виртуальной средой и для них эта статья не станет каким-либо открытием. Несмотря на это, есть компании, которые не используют гибкость и скорость работы виртуальных решений из-за недостатка точной информации о них. Мы надеемся, что наша статья поможет на примере понять, что гораздо проще один раз начать использовать виртуализацию, чем испытывать неудобства и недостатки физической инфраструктуры.

К счастью, попробовать как работает виртуализация достаточно просто. Мы покажем, как создать сервер в виртуальной среде, например, для переноса CRM-системы, используемой в компании. Практически любой физический сервер можно превратить в виртуальный, но вначале необходимо освоить базовые приемы работы. Об этом и пойдет речь ниже.

Как это устроено

Когда речь идет о виртуализации, многим начинающим специалистам сложно разобраться в терминологии, поэтому поясним несколько базовых понятий:

Ключевой особенностью является то, что любые действия виртуальных машин исполняются напрямую на уровне оборудования. При этом они друг от друга изолированы, что достаточно легко позволяет управлять ими по отдельности. Сам же гипервизор играет роль контролирующего органа, распределяя ресурсы, роли и приоритеты между ними. Также гипервизор занимается эмуляцией той части аппаратного обеспечения, которая необходима для корректной работы операционной системы.

Внедрение виртуализации дает возможность иметь в наличии несколько запущенных копий одного сервера. Критический сбой или ошибка, в процессе внесения изменений в такую копию, никак не повлияет на работу текущего сервиса или приложения. При этом также снимаются две основные проблемы – масштабирование и возможность держать «зоопарк» разных операционных систем на одном оборудовании. Это идеальная возможность совмещения самых разных сервисов без необходимости приобретения отдельного оборудования для каждого из них.

Виртуализация повышает отказоустойчивость сервисов и развернутых приложений. Даже если физический сервер вышел из строя и его необходимо заменить на другой, то вся виртуальная инфраструктура останется полностью работоспособной, при условии сохранности дисковых носителей. При этом физический сервер может быть вообще другого производителя. Это особенно актуально для компаний, которые используют серверы, производство которых прекращено и потребуется осуществить переход на другие модели.

Теперь перечислим самые популярные гипервизоры, существующие на текущий день:

KVM же напротив, полностью бесплатен и достаточно прост в работе, особенно в составе готового решения на базе Debian Linux под названием Proxmox Virtual Environment. Именно эту систему мы можем порекомендовать для первоначального знакомства с миром виртуальной инфраструктуры.

Как быстро развернуть гипервизор Proxmox VE

Установка чаще всего не вызывает никаких вопросов. Скачиваем актуальную версию образа с официального сайта и записываем его на любой внешний носитель с помощью утилиты Win32DiskImager (в Linux используется команда dd), после чего загружаем сервер непосредственно с этого носителя. Наши клиенты, арендующие у нас выделенные серверы, могут воспользоваться двумя еще более простыми путями – просто смонтировав нужный образ непосредственно из KVM-консоли, либо используя наш PXE-сервер.

Программа установки имеет графический интерфейс и задаст всего лишь несколько вопросов.

Веб-интерфейс управления станет доступен по адресу

Что нужно сделать после установки

Есть несколько важных вещей, которые следует выполнить после установки Proxmox. Расскажем о каждой из них подробнее.

Обновить систему до актуальной версии

Для этого зайдем в консоль нашего сервера и отключим платный репозиторий (доступен только тем, кто купил платную поддержку). Если этого не сделать — apt сообщит об ошибке при обновлении источников пакетов.

Позаботиться о безопасности

Исходя из практического опыта, за неделю работы сервера с открытым ssh-портом 22 и внешним статическим IPv4-адресом, было более 5000 попыток подобрать пароль. И около 1500 адресов утилита успешно заблокировала.

Для выполнения установки приводим небольшую инструкцию:

Проверить статус работы утилиты, например, снять статистику блокировок заблокированных IP-адресов с которых были попытки перебора паролей SSH, можно одной простой командой:

Ответ утилиты будет выглядеть примерно так:

Аналогичным способом можно закрыть от подобных атак Web-интерфейс, создав соответствующее правило. Пример такого правила для Fail2Ban можно найти в официальном руководстве.

Начало работы

Хочется обратить внимание на то, что Proxmox готов к созданию новых машин сразу после установки. Тем не менее, рекомендуем выполнить предварительные настройки, чтобы в дальнейшем системой было легко управлять. Практика показывает, что гипервизор и виртуальные машины стоит разнести по разным физическим носителям. О том, как это сделать и пойдет речь ниже.

Настроить дисковые накопители

ВНИМАНИЕ! Приведенный ниже пример дисковой разметки можно использовать только для тестовых целей. Для эксплуатации в реальных условиях мы настоятельно рекомендуем использовать программный или аппаратный RAID-массив, чтобы исключить потерю данных при выходе дисков из строя. О том, как правильно приготовить дисковый массив к работе и как действовать в случае аварийной ситуации мы расскажем в одной из следующих статей

Предположим, что физический сервер имеет два диска — /dev/sda, на который установлен гипервизор и пустой диск /dev/sdb, который планируется использовать для хранения данных виртуальных машин. Чтобы система смогла увидеть новое хранилище, можно воспользоваться самым простым и эффективным методом — подключить его как обычную директорию. Но перед этим следует выполнить некоторые подготовительные действия. В качестве примера посмотрим, как подключить новый диск /dev/sdb, любого размера, отформатировав его в файловую систему ext4.

Вывод команды должен показать, что /dev/sdb1 смонтирован в директорию /mnt/storage. Это значит, что наш накопитель готов к работе.

Добавить новое хранилище в Proxmox

Авторизуемся в панели управления и заходим в разделы Датацентр ➝ Хранилище ➝ Добавить ➝ Директория.

В открывшемся окне заполняем следующие поля:

После этого нажимаем кнопку Добавить. На этом настройка завершена.

Создать виртуальную машину

Для создания виртуальной машины выполняем следующую последовательность действий:

Создаем нашу первую виртуальную машину:

Настроить автозапуск

По умолчанию Proxmox автоматически не запускает машины, но это легко решается буквально двумя щелчками мыши:

Для продвинутых администраторов имеется еще и возможность указать дополнительные параметры запуска в разделе Start/Shutdown order. Можно явным образом указать в каком порядке следует запускать машины. Также можно указать время, которое должно пройти до старта следующей VM и время задержки выключения (если операционная система не успеет завершить работу, гипервизор принудительно ее выключит через определенное количество секунд).

Заключение

В этой статье были изложены основы того, как можно начать работать с Proxmox VE и мы надеемся, что она поможет начинающим специалистам сделать первый шаг и попробовать виртуализацию в действии.

Proxmox VE — это действительно очень мощный и удобный инструмент для любого системного администратора; главное не бояться экспериментировать и понять, как это действительно работает.

Если у вас появились вопросы, добро пожаловать в комментарии.