что нужно настроить чтобы поисковая система лучше находила и индексировала страницы вашего сайта

Что нужно настроить чтобы поисковая система лучше находила и индексировала страницы вашего сайта

Владелец сайта может влиять на то, как индексируется его ресурс.

Например, вы можете запросто закрыть для поисковой системы определённые разделы своего сайта. Для этого нужно добавить соответствующие команды в файл robots.txt — он находится в корневой папке сайта. Именно к этому файлу обращаются поисковые роботы, чтобы узнать, что можно индексировать, а что нет.

Поисковые системы исходят из того, что индексировать можно всё, что не запрещено. Поэтому владельцу сайта нужно самому позаботиться о том, чтобы в поиск не попала конфиденциальная информация — например, личные данные пользователей, их переписка или счета. Такие страницы нужно запретить индексировать. Рекомендуем также закрыть страницы со служебной информацией и страницы-дубликаты.

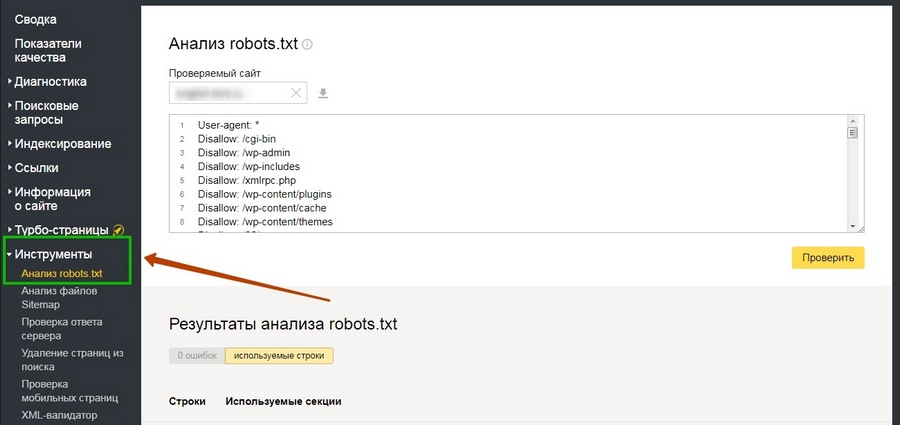

Многие системы управления сайтами (CMS) автоматически создают файл robots.txt и команды для роботов. Яндекс.Вебмастер позволяет проверить файл robots.txt на наличие ошибок. Для этого нужно загрузить содержимое файла в инструмент «Анализатор robots.txt». Для этого можно просто скопировать данные файла и вставить их в форму. Или загрузить файл robots.txt через интерфейс сервиса.

Сервис проверит файл и покажет, есть ли в нём ошибки.

Теперь поговорим о том, как создать правило для робота. Каждое правило состоит из двух элементов: это обращение к роботу и команда.

Если вы хотите обратиться сразу ко всем роботам, используйте элемент «User-agent:*». Для обращения только к роботу Яндекса нужно выбрать элемент «User-agent: Yandex».

Вы можете дать роботу команду «Allow:» (разрешить индексирование) или «Disallow:» (запретить индексирование). После команды нужно указать адрес, для которого должна применяться команда.

Например, так будет выглядеть правило, запрещающее всем поисковым роботам индексировать раздел siteforyandex.ru/admin:

Анализатор помогает найти ошибки в файле robots.txt, проверить, все ли команды прописаны верно и понятны роботу, и узнать, разрешена ли к индексированию конкретная страница.

Файл robots.txt позволяет закрыть для индексирования весь контент страницы. Если вы хотите закрыть только какую-то часть контента, используйте тег noindex. Этот тег не даёт индексировать заключенный в него текст, но не мешает поисковой системе переходить по ссылкам внутри текста.

Совет

Чтобы узнать, какие разделы сайта и в каком объёме уже проиндексированы, воспользуйтесь инструментом «Структура сайта» в Яндекс.Вебмастере, он находится в разделе «Индексирование».

Как ускорить индексацию сайта в Яндексе и Google

В статье:

Быстрое индексирование страниц — это хорошо. Чем быстрее страница займет место в выдаче поисковой системы, тем быстрее ее смогут увидеть пользователи. А также эта страница с большей вероятностью будет считаться первоисточником контента, который на ней находится.

К сожалению, нельзя точно сказать, когда боты поисковых систем просканируют страницу и она появится в выдаче — это зависит от размера и оптимизации сайта.

Частые проблемы с индексацией сайта в ПС

Страницы вообще не индексируются

Если роботы и Яндекса, и Google игнорируют страницы сайта, нужно убедиться, что ботам не запретили обход. Проверьте настройки хостинга и файл robots.txt — там не должно быть запрета на индексацию.

Страницы не индексируются одним из поисковиков

Если либо Google, либо Яндекс не индексируют страницы сайта, проблема может быть в санкциях от этого поисковика. Нужно определить, какие санкции лежат на сайте, и исправить ошибки. Помогут материалы о санкциях Яндекса и фильтрах Google.

Страницы индексируются, но долго

Если приходится долго ждать индексации новых страниц, вариантов может быть много: контент редко обновляется и поэтому боты редко его посещают, страницы не оптимизированы, не участвуют в перелинковке или что-то еще.

Посмотреть динамику индексации страниц и наличие фильтров можно в Анализе сайта:

Итак, если страницы не индексируются, то проверьте ограничения, если игнор от одного из ПС, то возможны санкции, а если индексирование идет, но долго, это повод попытаться его ускорить. Посмотрим, что можно сделать.

Как ускорить индексацию страниц

Представитель Google Джон Мюллер на вопрос об индексировании ответил так:

«Лучший способ улучшить процесс индексирования – создавать превосходный, а значит уникальный и убедительный контент. Именно в нем должны нуждаться пользователи, именно его они затем будут рекомендовать другим. Нужно также понимать, что поисковые системы не индексируют абсолютно все, что выложено в сети».

Создавайте превосходный контент, а если ваш контент плохо индексируется, то он недостаточно превосходный 🙂 Это все, конечно, хорошо, но давайте посмотрим, что конкретно можно сделать, чтобы ускорить процесс.

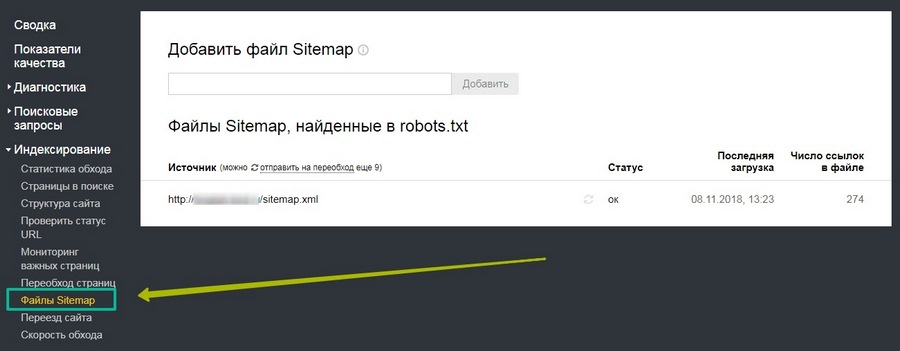

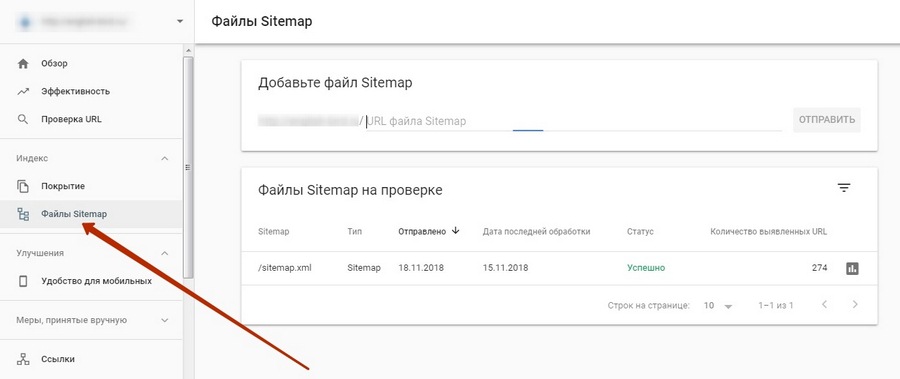

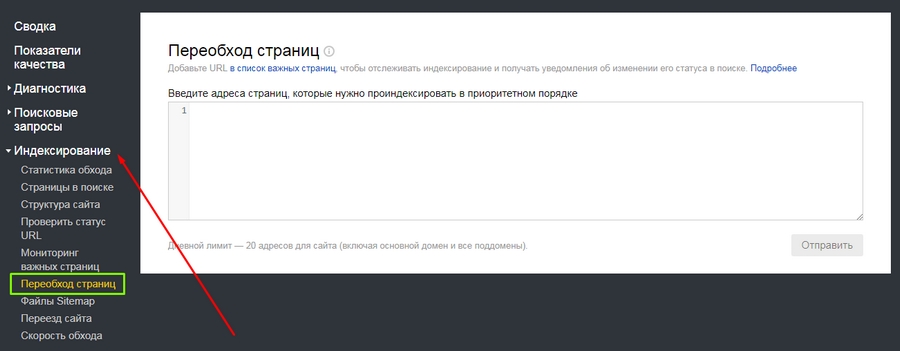

Отправить страницу на переобход

Можно дополнительно обратить внимание поисковиков на конкретные URL. В Google Search Console и Яндекс.Вебмастер найдите переобход страниц и отправьте нужные URL на индексацию.

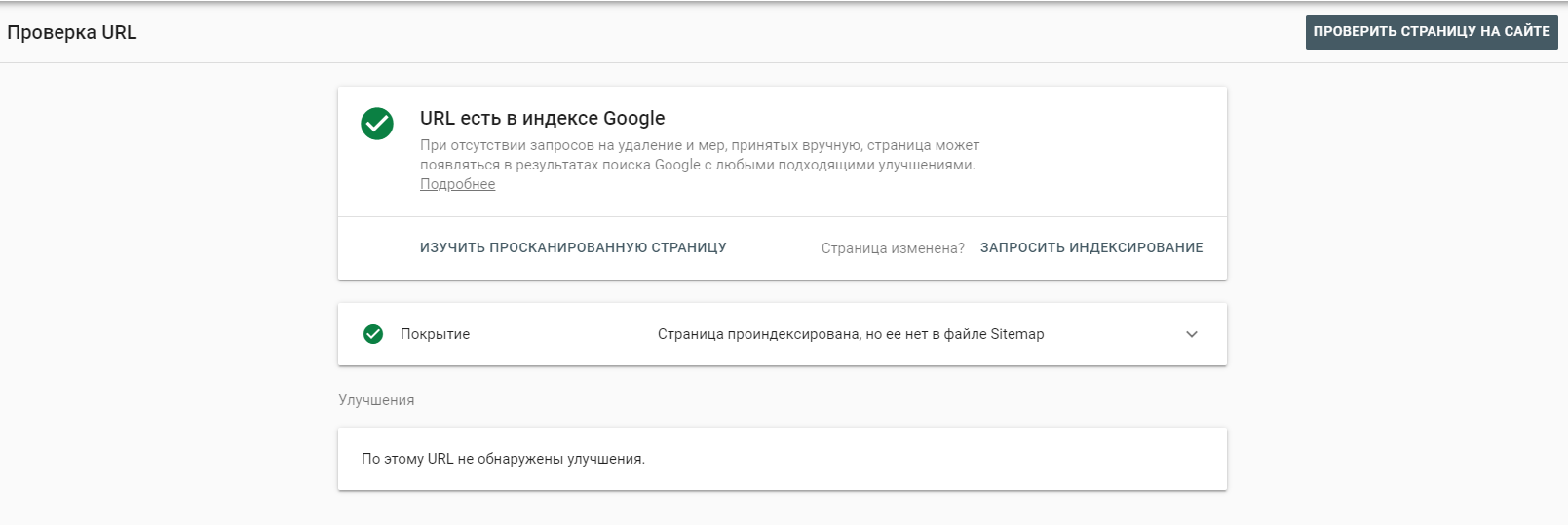

В Яндекс.Вебмастере это раздел Индексирование — Переобход страниц. В консоли Google это Инструмент проверки URL.

Проверить разрешения в robots.txt

В файле robots.txt веб-мастер прописывает рекомендации для поисковых ботов Яндекса и Google. Можно запретить ботам посещать некоторые страницы, для этого есть директива «disallow», «nofollow», можно использовать мета-тег «noindex» или «none». Тогда при следующем посещении сайта бот увидит запрет и может к нему прислушаться. А может и не прислушаться.

Как говорит Ксения Пескова, SEO-TeamLead в Siteclinic:

«Если вы закроете сканирование в файле robots.txt — это всё равно может не уберечь от индексации страницы, так как в файле мы запрещаем сканирование, и это всего лишь рекомендации, а не прямое указание».

В любом случае, лучше проверить файл robots, вдруг там стоят запреты, к которым прислушались боты поисковых систем.

Создать Sitemap — Карту сайта

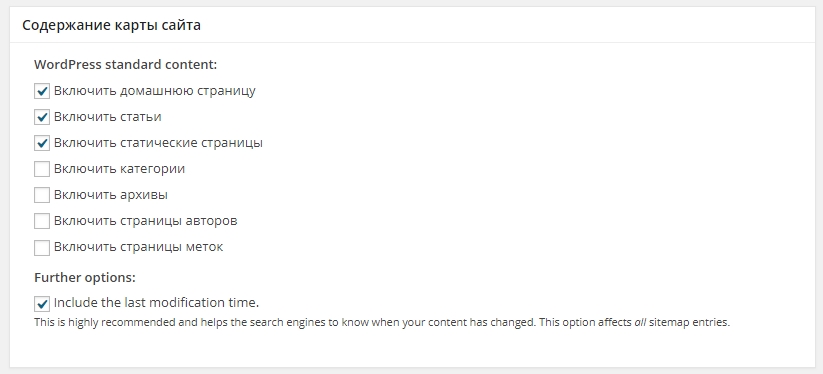

Карта сайта помогает поисковым ботам понять структуру ресурса и обнаруживать обновления контента.

Для ускорения индексации карту можно сделать динамической, то есть по мере создания новых страниц она сама будет обновляться. Для проектов на конструкторах сайтов, например, на WIX и Tilda, карта по умолчанию динамическая, для других CMS есть плагины и отдельные сервисы. К примеру, на WordPress с этой задачей справится All in One SEO Pack.

Но опять же, ссылки в Карте сайта — это рекомендации, важнее создать грамотную структуру сайта и организовать внутреннюю перелинковку.

Проверить структуру и перелинковку разделов

На сайте не должно быть страниц, оторванных от других. Если на страницу не ведут ссылки с категорий, разделов и других страниц, поисковикам сложнее определить ее релевантность и неоткуда перейти на нее для сканирования. Такие страницы называют сиротами.

Нужно встроить их в структуру сайта. К примеру, в этой схеме каждая страница имеет ссылку с родительской категории, но они вполне могут линковаться и между собой:

Еще один момент, который влияет на поведение бота — это Click Distance from Index (DFI), то есть количество кликов от главной до текущей страницы. Чем оно меньше, тем важнее считается страница, тем больший приоритет она получит с точки зрения бота. Приоритетные страницы он смотрит первее остальных.

DFI не определяется по числу директорий в URL, они могут не совпадать. Например, если на главной странице будет ссылка на хит продаж — конкретную модель холодильника Atlant, то DFI будет равен двум. Но при этом карточка модели может находиться в каталоге и подразделе каталога, тогда директорий будет больше — site.com/shop/refrigerator/one_chamber_refrigerators/atlant/h_1401_100.

Если страница не индексируется, проверьте ее расположение в структуре сайта и количество кликов до нее с главной.

Взять за правило обновлять контент

Поисковики ценят, когда веб-мастер следит за актуальностью контента, исправляет его и добавляет что-то новое. Регулярно обновляющийся сайт бот будет чаще сканировать. Чем реже обновлять контент, тем реже боту понадобится его перепроверять.

Сотрудник Google советовал добавлять на страницу видео с Youtube, если странице нечего добавить и содержание еще актуально. Поведенческие улучшатся за счет просмотра видео, на странице появится новый формат контента — это тоже хороший сигнал для поисковика.

Публиковать ссылки в соцсетях и на других площадках

Если вы ведете страницы в социальных сетях, размещайте на них анонсы ваших новых материалов. С помощью разметки OpenGraph можно задать ссылке красивое превью с нужной картинкой и заголовком, и получить переходы пользователей на страницу.

Найдите сторонние площадки по вашей тематике, где можно оставлять ссылки или публиковать посты, и размещайте таким образом ссылки на новые материалы. Ссылки должны быть естественными и подходить по теме. Используйте пресс-релизы, форумы, другие соцсети, отзовики, сервисы вопросов и ответов и другие площадки.

Ускорить загрузку сайта

Ограничивать индексацию может долгий ответ сервера. По словам Джона Мюллера из Google, сли в среднем это время составляет больше одной секунды, Google не будет сканировать столько страниц, сколько мог бы.

Медленная загрузка страниц вредит им по всем параметрам: пользователи не ждут, ПС считают некачественными, могут даже понизить сайт в выдаче, если сайт в принципе медленный.

Многое из перечисленного можно проверить на сайте автоматически. Поможет сервис «Анализ сайта»: проверит сайт по 70+ тестам, оценит и главную, и внутренние страницы, найдет ошибки и даст советы по исправлению.

Многие функции сервиса и графики доступны на платных тарифах Анализа, но вы можете попробовать неделю бесплатно и оценить все возможности.

До конца лета на любой тариф «Анализа сайта» действует скидка 30% по промокоду LAST_DAYS.

Промокод сработает сразу при переходе на страницу —> Купить со скидкой

FAQ: что еще влияет на скорость индексации сайта

Как страницы вне индекса могут повлиять на отношение поисковика к сайту?

Качество контента на сайте поисковики оценивают только по проиндексированным страницам.

Тег noindex может влиять на индексацию страницы после его снятия?

По словам Джона Мюллера из Google, у веб-мастера не будет проблем с реиндексацией URL, на которых когда-то был noindex.

Как редирект влияет на индексацию страниц?

Джон Мюллер утверждает, что поисковик скорее всего не проиндексирует конечный URL при использовании ссылок с 301 редиректом.

Как ускорить индексацию страниц, которые были 404?

Если адрес страницы отдавал 404 и не был индексирован, на индексирование может потребоваться некоторое время. Как советуют Seroundtable, можно создать новый URL для этого контента и настроить 301 редирект со старого адреса, либо запросить повторное сканирование URL.

Как поисковики относятся к URL c хэшами?

URL с хешами поисковик не проиндексирует. То есть ссылка https://site.ru/news/p/statya проиндексируется, а ссылка на конкретную часть статьи — https://site.ru/news/p/statya#step — нет.

Расскажите в комментариях, что мы упустили в материале, какие способы ускорить попадание в индекс используете вы.

Как проиндексировать сайт в Яндексе, Google и других поисковиках

Индексирование сайта — что это и для чего необходимо?

Индексация сайта в поисковых системах — необходимое условие его видимости при поиске в интернете. Если просто создать сайт и не заботиться о его индексации, скорее всего, на него смогут попасть только те, кто знает непосредственный адрес домена.

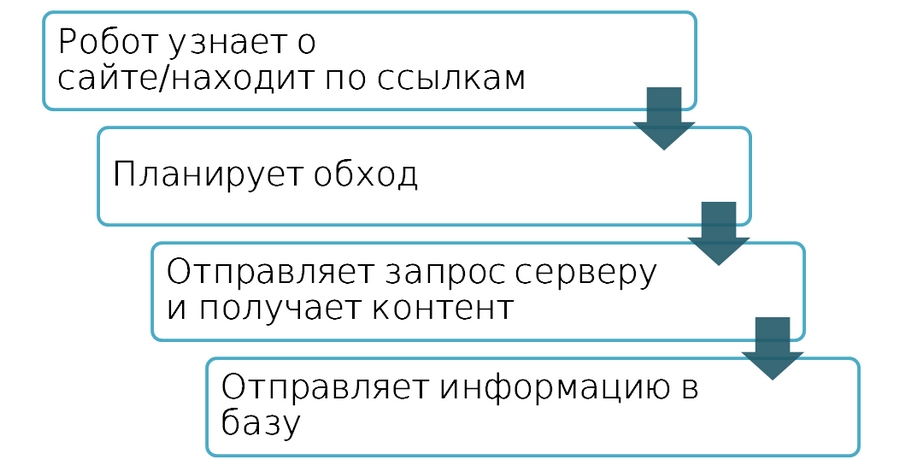

Индексирование — это процесс считывания страниц сайта роботом той или иной поисковой системы с последующим добавлением данных страниц в базу поисковой системы

Краулеры с некоторой периодичностью обходят страницы сайта, считывая

И множество других данных.

Благодаря тому, что поисковая система узнаёт о сайте, она способна предлагать и продвигать его в результатах поиска. На основе контента, ссылок и ряда факторов определяется тематическая категория сайта, ключевые фразы, по которым он наиболее релевантен поисковым запросам.

Таким образом, поисковая система предлагает пользователям страницы вашего сайта, максимально соответствующие их запросам.

Индексация всего лишь способствует актуализации материалов сайта. Благодаря этому страницы и их содержимое, во-первых, попадают в поисковую выдачу с наименьшей задержкой. А, во-вторых, постоянно обновляются.

Как эффективно проиндексировать сайт

Чтобы сайт как можно быстрее начали индексировать поисковые системы, его надо добавить в базу поисковиков через инструменты для вебмастеров.

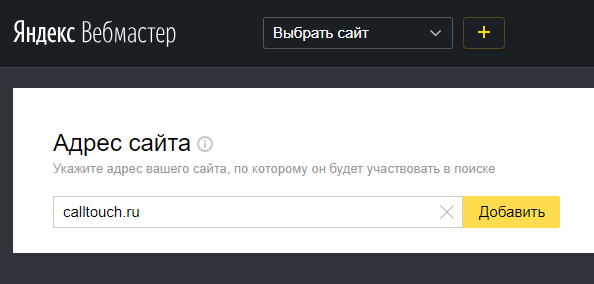

Добавьте сайт в Яндекс.Вебмастер

Простой ответ на вопрос «Как проиндексировать сайт в Яндексе?» — добавить его в Вебмастер.

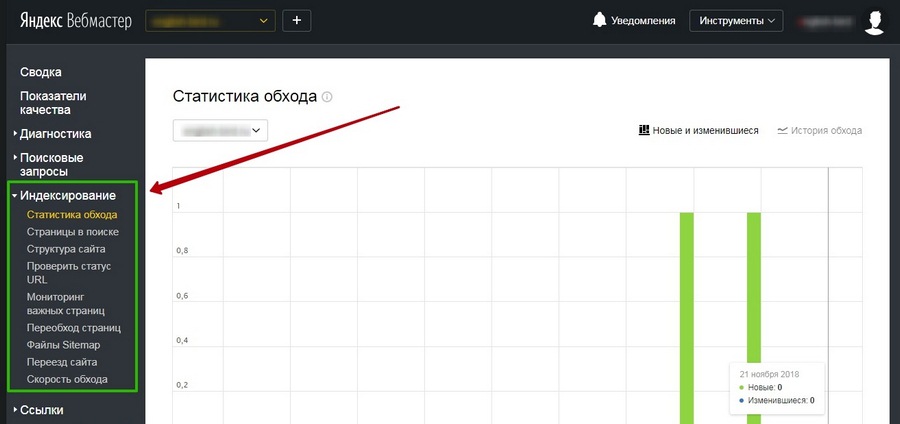

В том же меню есть информация о том, когда и с каким результатом робот обходил страницы, какие из них есть в поиске, а также функция добавления Sitemap, запуска переобхода и настройки скорости обхода.

Добавьте сайт в Google Search Console

Перейдите на https://search.google.com/search-console/welcome и войдите в учётную запись. Добавьте сайт в систему.

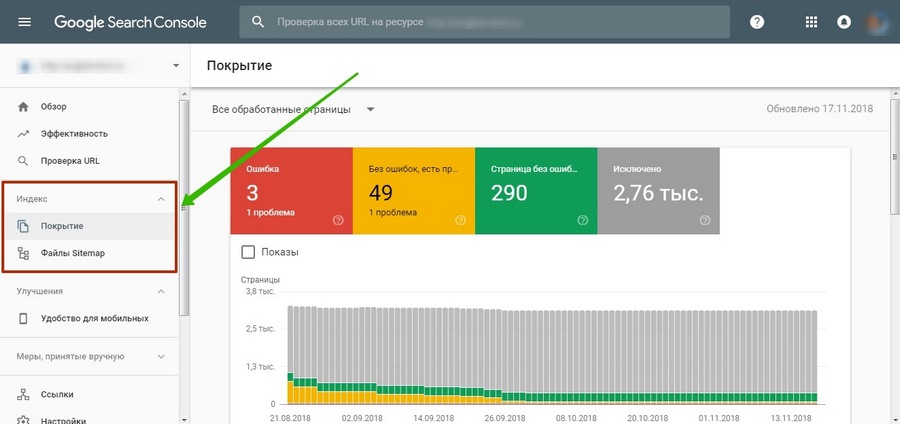

Как и в Яндекс.Вебмастере, инструмент предлагает множество отчётов о состоянии индексации сайта. Вы может увидеть, какие страницы проиндексированы и добавлены в поиск, внутренние и внешние ссылки и многое другое.

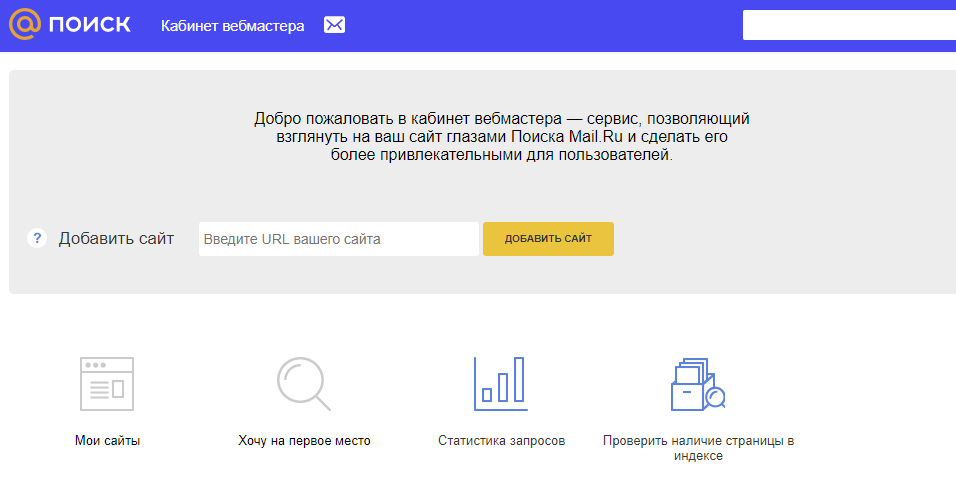

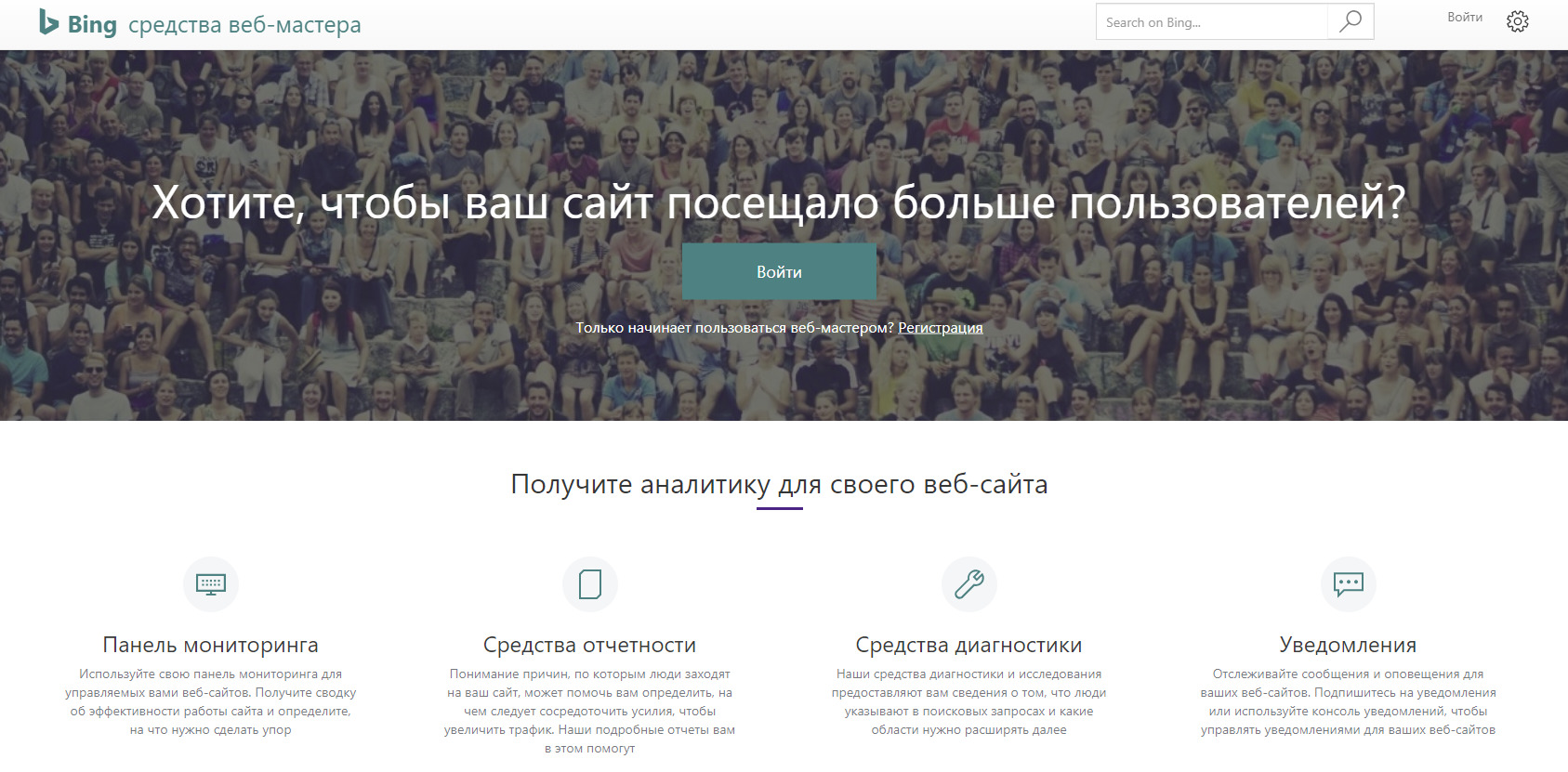

Добавление сайта в прочие поисковые системы

В российском сегменте интернета доля поисковых систем помимо Яндекса и Google стремится к нулю. Тем не менее, не следует ими пренебрегать, если сайт является важным имиджевым элементом крупного проекта или организации.

Рамблер основан на тех же данных индексации, которые собирает Яндекс — в этом случае нет необходимости в дополнительных настройках.

Как ускорить индексацию сайта в поисковиках

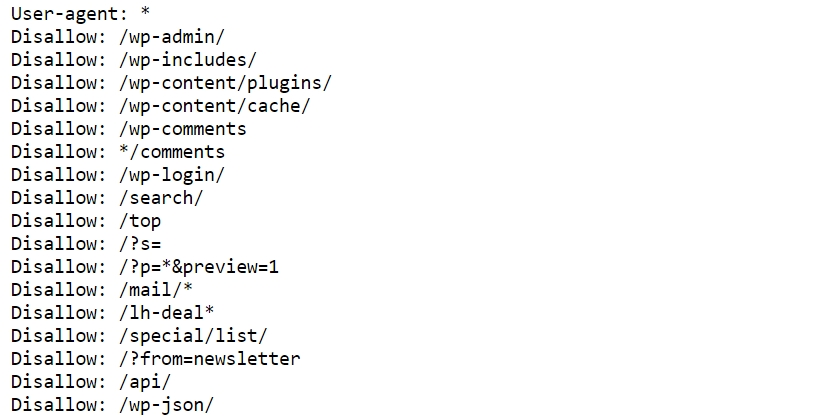

Создайте файл robots.txt

Файл robots.txt даёт поисковым роботам указание — какие страницы и разделы сайта следует читать, а какие — нет.

На сайте всегда присутствуют технические страницы — в частности, результаты поиска, этапы регистрации, системные файлы, теги и подобное. Также со временем может скопиться некоторый объём неактуальных страниц — контент на них может быть устаревшим или наоборот, он ждёт публикации не ранее назначенной даты.

Как приручить поискового бота: гайд по индексированию сайта

Если интернет – огромная библиотека, то поисковые системы – ее сверхбыстрые сотрудники, способные быстро сориентировать читателя (интернет-пользователя) в бескрайнем океане информации. В этом им помогает систематизированная картотека – собственная база данных.

Когда пользователь вводит ключевую фразу, поисковая система показывает результаты из этой базы данных. То есть ПС хранят на своих серверах копии документов и обращаются к ним, когда пользователь отправляет запрос. Чтобы представить в выдаче определенную страницу, ее нужно сперва добавить в базу (индекс). Поэтому только что созданные сайты, о которых поисковики не знают, в выдаче не участвуют.

Поисковая система отправляет своего робота (он же паук, он же краулер) на поиски новых страниц, которые появляются в сети ежесекундно. Паучья стая собирает данные, передвигаясь по ссылкам с одной страницы на другую, и передает их в базу. Обработку информации производят уже другие механизмы.

У каждой поисковой системы – свой набор ботов, выполняющих разные функции. Вот пример некоторых роботов «Яндекса»:

У «Гугла» тоже есть свой робот для сканирования новостей и картинок, а еще – индексатор видео, мобильных сайтов и т. д.

Скорость индексирования новых сайтов у разных ПС отличается. Каких-то конкретных сроков здесь нет, есть лишь примерные временные рамки: для «Яндекса» – от одной недели до месяца, для Google – от нескольких минут до недели. Чтобы не ждать индексации неделями, нужно серьезно поработать. Об этом и пойдет речь в статье.

Сперва давайте узнаем, как проверить, проиндексирован ли сайт.

Как проверить индексацию сайта

Проверить индексацию можно тремя основными способами:

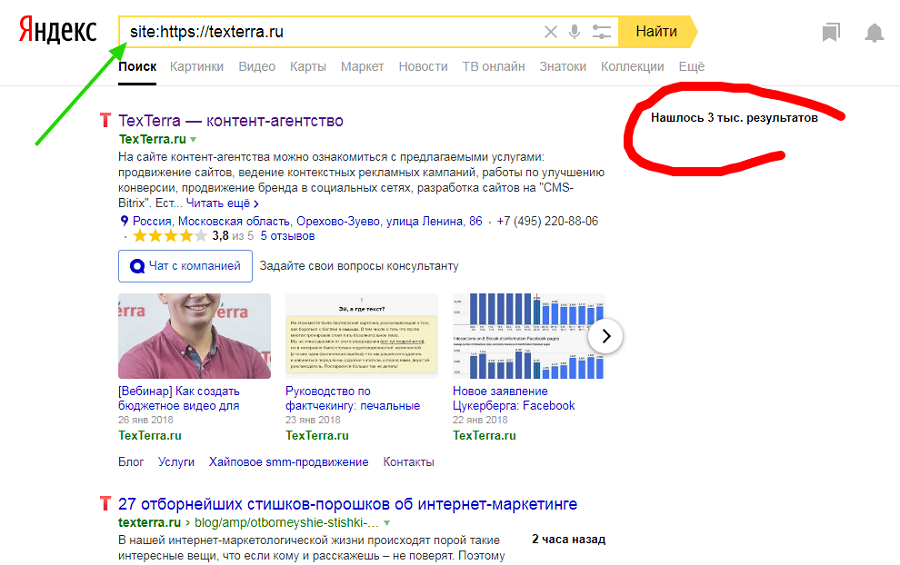

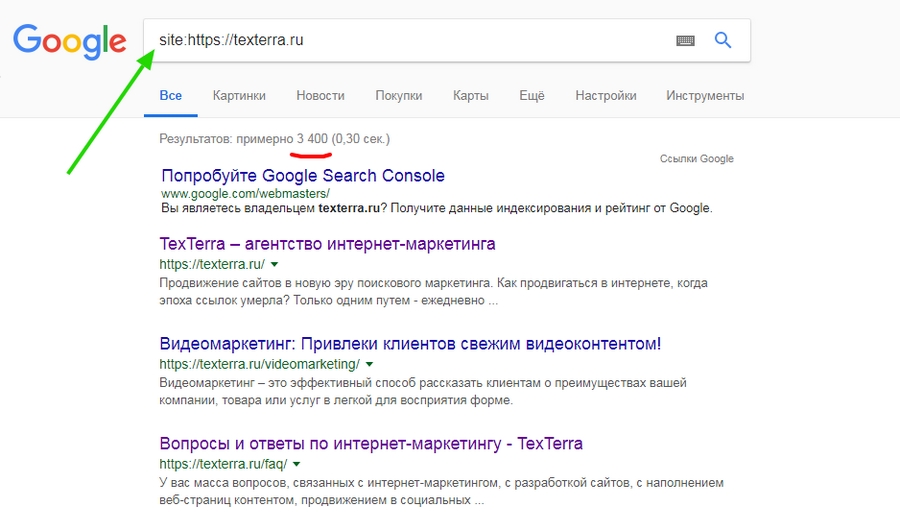

Поисковые операторы

Быстро и просто примерное количество проиндексированных страниц можно узнать с помощью оператора site. Он действует одинаково в «Яндекс» и «Гугл».

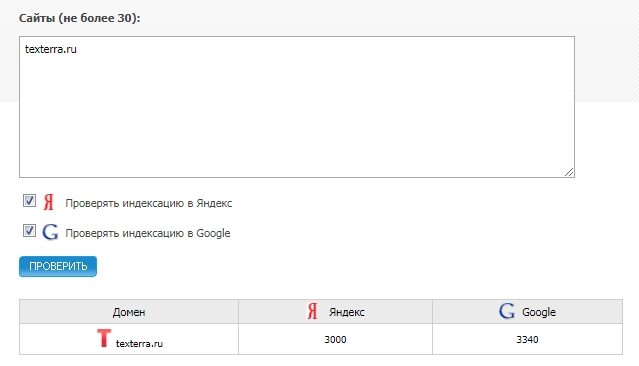

Сервисы для проверки индексации

Бесплатные сервисы позволяют быстро узнать количество проиндексированных «Яндексом» и Google страниц. Есть, к примеру, очень удобный инструмент от XSEO.in и SEOGadget (можно проверять до 30 сайтов одновременно).

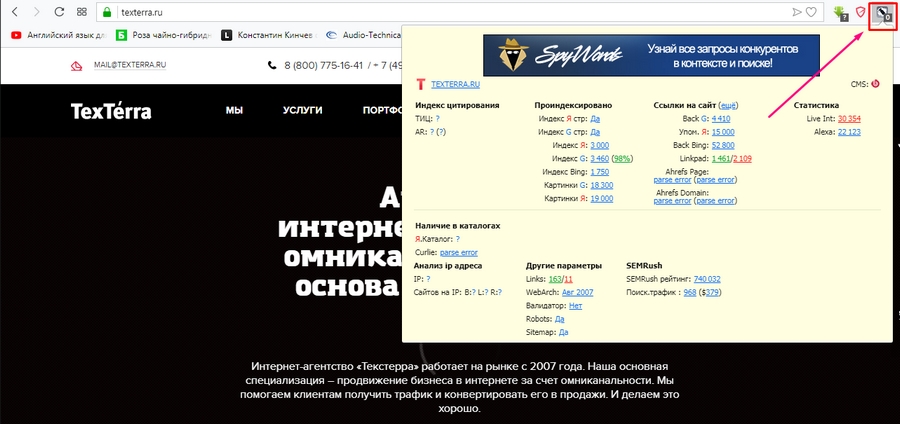

У RDS целая линейка полезных инструментов для проверки показателей сайтов, в том числе проиндексированных страниц. Можно скачать удобный плагин для браузера (поддерживаются Chrome, Mozilla и Opera) или десктопное приложение.

Вообще плагин больше подходит профессиональным SEOшникам. Если вы обычный пользователь, будьте готовы, что эта утилита будет постоянно атаковать вас лишней информацией, вклиниваясь в код страниц, и в итоге придется либо ее настраивать, либо удалять.

Панели вебмастера

«Яндекс.Вебмастер» и Google Search Console предоставляют подробную информацию об индексировании. Так сказать, из первых уст.

В старой версии GSC можно также посмотреть статистику сканирования и ошибки, с которыми сталкиваются роботы при обращении к страницам.

Подробнее о данных об индексировании, представленных в панелях вебмастеров, можно почитать в соответствующих разделах наших руководств по «Яндекс.Вебмастеру» и Google Search Console.

Как контролировать индексацию

Поисковые системы воспринимают сайты совсем не так, как мы с вами. В отличие от рядового пользователя, поисковый робот видит всю подноготную сайта. Если его вовремя не остановить, он будет сканировать все страницы, без разбора, включая и те, которые не следует выставлять на всеобщее обозрение.

При этом нужно учитывать, что ресурсы робота ограничены: существует определенная квота – количество страниц, которое может обойти паук за определенное время. Если на вашем сайте огромное количество страниц, есть большая вероятность, что робот потратит большую часть ресурсов на «мусорные» страницы, а важные оставит на будущее.

Поэтому индексированием можно и нужно управлять. Для этого существуют определенные инструменты-помощники, которые мы далее и рассмотрим.

Robots.txt

Robots.txt – простой текстовый файл (как можно догадаться по расширению), в котором с помощью специальных слов и символов прописываются правила, которые понимают поисковые системы.

Директивы, используемые в robots.txt:

Описание

Обращение к роботу.

Адрес главного зеркала.

Время задержки между скачиванием страниц сайта.

Страницы с какими параметрами нужно исключить из индекса.

User-agent показывает, к какому поисковику относятся указанные ниже правила. Если адресатом является любой поисковик, пишем звездочку:

User-agent: Slurp (поисковый робот Yahoo!)

Самая часто используемая директива – disallow. Как раз она используется для запрета индексирования страниц, файлов или каталогов.

К страницам, которые нужно запрещать, относятся:

На дублях остановимся подробнее. Представьте, что у вас есть страница блога со статьей. Вы прорекламировали эту статью на другом ресурсе, добавив к существующему URL UTM-метку для отслеживания переходов. Адрес немного изменился, но он все еще ведет на ту же страницу – контент полностью совпадает. Это дубль, который нужно закрывать от индексации.

Не только системы статистики виноваты в дублировании страниц. Дубли могут появляться при поиске товаров, сортировке, из-за наличия одного и того же товара в нескольких категориях и т. д. Даже сами движки сайта часто создают большое количество разных дублей (особенно WordPress и Joomla).

Помимо полных дублей существуют и частичные. Самый лучший пример – главная страница блога с анонсами записей. Как правило, анонсы берутся из статей, поэтому на таких страницах отсутствует уникальный контент. В этом случае анонсы можно уникализировать или вовсе убрать (как в блоге Texterra).

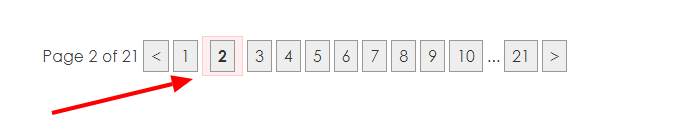

У подобных страниц (списки статей, каталоги товаров и т. д.) также присутствует постраничная навигация (пагинация), которая разбивает список на несколько страниц. О том, что делать с такими страницами, Google подробно расписал в своей справке.

Дубли могут сильно навредить ранжированию. Например, из-за большого их количества поисковик может показывать по определенным запросам совершенно не те страницы, которые вы планировали продвигать и на которые был сделан упор в плане оптимизации (например, есть усиленная ссылками страница товара, а поисковик показывает совершенно другую). Поэтому важно правильно настроить индексацию сайта, чтобы этой проблемы не было. Как раз один из способов борьбы с дублями – файл robots.txt.

Пример robots.txt для одного известного блога:

При составлении robots.txt можно ориентироваться на другие сайты. Для этого просто добавьте в конце адреса главной страницы интересующего сайта после слеша «robots.txt».Не забывайте только, что функционал у сайтов разный, поэтому полностью скопировать директивы топовых конкурентов и жить спокойно не получится. Даже если вы решите скачать готовый robots.txt для своей CMS, в него все равно придется вносить изменения под свои нужды.

Давайте разберемся с символами, которые используются при составлении правил.

Путь к определенному файлу или папке мы указываем через слеш (/). Если указана папка (например, /wp-admin/), все файлы из этой папки будут закрыты для индексации. Чтобы указать конкретный файл, нужно полностью указать его имя и расширение (вместе с директорией).

Если, к примеру, нужно запретить индексацию файлов определенного типа или страницу, содержащую какой-либо параметр, можно использовать звездочки (*):

Запретить индексацию страниц с определенными параметрами также можно с помощью директивы clean-param. Подробнее об этом можно прочитать в справке «Яндекса».

Директива allow разрешает индексирование отдельных каталогов, страниц или файлов. Например, нужно закрыть от ПС все содержимое папки uploads за исключением одного pdf-файла. Вот как это можно сделать:

Следующая важная (для «Яндекса») директива – host. Она позволяет указать главное зеркало сайта.

У сайта может быть несколько версий (доменов) с абсолютно идентичным контентом. Даже если у вас домен единственный, не стоит игнорировать директиву host, это разные сайты, и нужно определить, какую версию следует показывать в выдаче. Об этом мы уже подробно писали в статье «Как узнать главное зеркало сайта и настроить его с помощью редиректа».

Еще одна важная директива – sitemap. Здесь (при наличии) указывается адрес, по которому можно найти карту вашего сайта. О том, как ее создать и для чего она нужна, поговорим позже.

Наконец, директива, которая применяется не так часто – crawl-delay. Она нужна в случае, когда нагрузка на сервер превышает лимит хостинга. Такое редко встречается у хороших хостеров, и без видимых причин устанавливать временные ограничения на скачивание страниц роботам не стоит. К тому же скорость обхода можно регулировать в «Яндекс.Вебмастере».

Нужно отметить, что поисковые системы по-разному относятся к robots.txt. Если для «Яндекса» это набор правил, которые нельзя нарушать, то «Гугл» воспринимает его, скорее, как рекомендацию и может проигнорировать некоторые директивы.

В robots.txt нельзя использовать кириллические символы. Поэтому если у вас кириллический домен, используйте онлайн-конвертеры.

После создания файла его нужно поместить в корневой каталог сайта, т. е.: site.ru/robots.txt.

Проверить robots.txt на наличие ошибок можно в разделе «Инструменты» панели «Яндекс.Вебмастер»:

В старой версии Google Search Console тоже есть такой инструмент.

Как закрыть сайт от индексации

Если вам по какой-то причине нужно, чтобы сайт исчез из выдачи всех поисковых систем, сделать это очень просто:

Крайне желательно делать это, пока сайт находится в разработке. Чтобы снова открыть сайт для поисковых роботов, достаточно убрать слеш (главное – не забыть это сделать при запуске сайта).

Nofollow и noindex

Для настройки индексации используются также специальные атрибуты и html-теги.

Проблема в том, что этот тег практически никто кроме «Яндекса» не понимает, поэтому при проверке кода большинство валидаторов выдают ошибки. Это можно исправить, если слегка изменить внешний вид тегов:

Кстати, на мега-теге robots стоит остановиться подробнее. Как и файл robots.txt, он позволяет управлять индексацией, но более гибко. Чтобы понять принцип работы, рассмотрим варианты инструкций:

индексировать контент и ссылки

не индексировать контент и ссылки

не индексировать контент, но переходить по ссылкам

индексировать контент, но не переходить по ссылкам

Это далеко не все примеры использования мета-тега robots, так как помимо nofollow и noindex существуют и другие директивы. Например, noimageindex, запрещающая сканировать изображения на странице. Подробнее почитать об этом мета-теге и его применении можно в справке от Google.

Rel=”canonical”

Еще один способ борьбы с дублями – использование атрибута rel=”canonical”. Для каждой страницы можно задать канонический (предпочитаемый) адрес, который и будет отображаться в поисковой выдаче. Прописывая атрибут в коде дубля, вы «прикрепляете» его к основной странице, и путаницы c ee версиями не возникнет. При наличии у дубля ссылочного веса он будет передаваться основной странице.

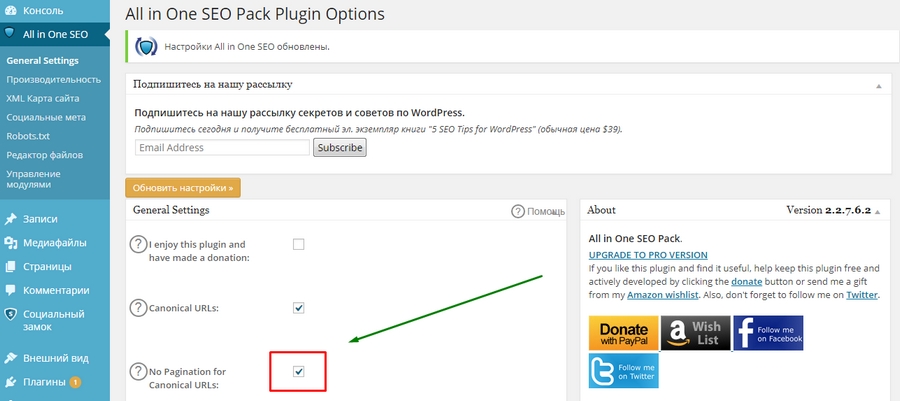

Вернемся к примеру с пагинацией в WordPress. С помощью плагина All in One SEO можно в один клик решить проблему с дублями этого типа. Посмотрим, как это работает.

Зайдем главную страницу блога и откроем, к примеру, вторую страницу пагинации.

Каноническая ссылка установлена неправильно – она просто повторяет физический адрес страницы. Это нужно исправить. Переходим в общие настройки плагина All in One SEO и отмечаем галочкой пункт «No Pagination for Canonical URLs» (Запретить пагинацию для канонических URL).

После обновления настроек снова смотрим код, теперь должно быть вот так:

И так – на любой странице, будь то вторая или двадцатая. Быстро и просто.

Но есть одна проблема. Для Google такой способ не подходит (он сам об этом писал), и использование атрибута canonical может негативно отразиться на индексировании страниц пагинации. Если для блога это, в принципе, не страшно, то со страницами товаров лучше не экспериментировать, а использовать атрибуты rel=”prev” и rel=”next”. Только вот «Яндекс» их, по словам Платона Щукина, игнорирует. В общем, все неоднозначно и ничего не понятно, но это нормально – это SEO.

Sitemap (карта сайта)

Если файл robots.txt указывает роботу, какие страницы ему трогать не надо, то карта сайта, напротив, содержит в себе все ссылки, которые нужно индексировать.

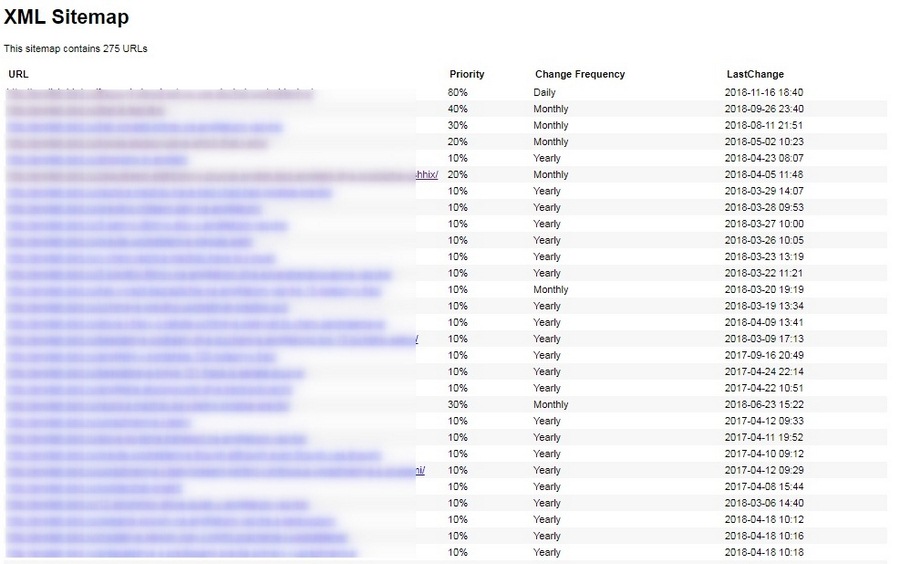

Главный плюс карты сайта в том, что помимо перечня страниц она содержит полезные для робота данные – дату и частоту обновлений каждой страницы и ее приоритет для сканирования.

Файл sitemap.xml можно сгенерировать автоматически с помощью специализированных онлайн-сервисов. Например, Gensitemap (рус) и XML-Sitemaps (англ). У них есть ограничения на количество страниц, поэтому если у вас большой сайт (больше 1000 страниц), за создание карты придется заплатить символическую сумму. Также получить готовый файл можно с помощью плагина. Самый простой и удобный плагин для WordPress – Google XML Sitemaps. У него довольно много разных настроек, но в них несложно разобраться.

В результате получается простенькая и удобная карта сайта в виде таблички. Причем она становится доступной сразу после активации плагина.

Sitemap крайне полезен для индексации, так как зачастую роботы уделяют большое внимание старым страницам и игнорируют новые. Когда есть карта сайта, робот видит, какие страницы изменились, и при обращении к сайту в первую очередь посещает их.

Если вы создали карту сайта при помощи сторонних сервисов, готовый файл необходимо скачать и поместить, как и robots.txt, в папку на хостинге, где расположен сайт. Опять же, в корневой папке: site.ru/sitemap.xml.

Для удобства желательно загрузить полученный файл в специальный раздел в «Яндекс.Вебмастере» и Google Search Console.

В старой версии инструмент немного отличается.

В «Яндекс.Вебмастере» проверить содержимое карты сайта на наличие ошибок можно в разделе «Инструменты».

Как ускорить индексацию

Поисковые системы рано или поздно узнают о вашем сайте, даже если вы ничего для этого не сделаете. Но вы наверняка хотите получать клиентов и посетителей как можно раньше, а не через месяцы, поэтому затягивать с индексацией – себе в убыток.

Регулярное быстрое индексирование необходимо не только новым, но и действующим сайтам – для своевременного обновления данных в поиске. Представьте, что вы решили оптимизировать старые непривлекательные заголовки и сниппеты, чтобы повысить CTR в выдаче. Если ждать, пока робот сам переиндексирует все страницы, можно потерять кучу потенциальных клиентов.

Вот еще несколько причин, чтобы как можно быстрее «скормить» роботам новые странички:

Ускорение индексации – работа комплексная. Каких-то конкретных способов здесь нет, так как каждый сайт индивидуален (как и серверы, на которых они расположены). Но можно воспользоваться общими рекомендациями, которые, как правило, позитивно сказываются на скорости индексирования.

Перечислим кратко, что можно сделать, чтобы сайт индексировался быстрее:

Еще в панелях «Яндекс.Вебмастера» и Google Search Console можно отправлять роботов на конкретные страницы.

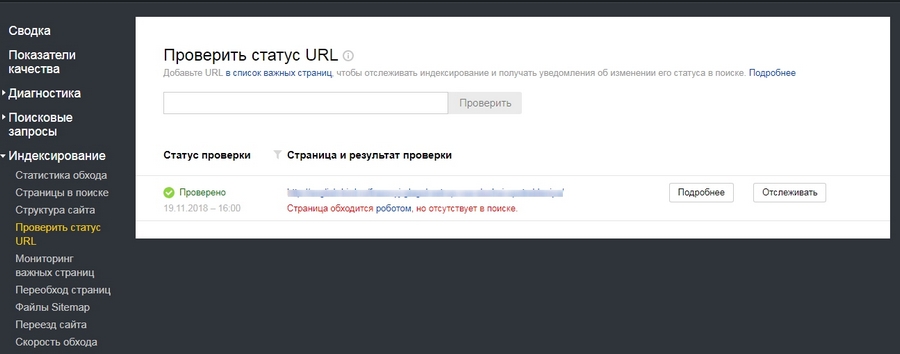

Обратите внимание на то, что отдельные адреса можно добавить в важные, чтобы потом отслеживать их индексирование.

А вот еще одна полезная штука: здесь можно узнать, проиндексирован ли конкретный URL.

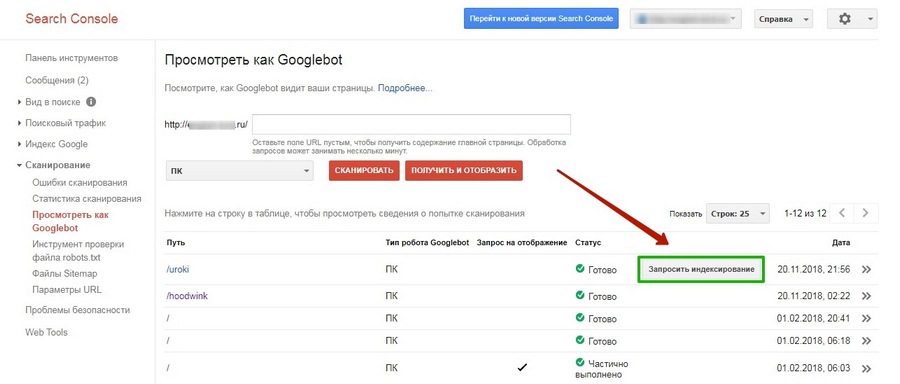

В Google запросить индексирование конкретных страниц можно во вкладке «Посмотреть как Googlebot» (старая версия).

Это, пожалуй, самые основные способы ускорения индексации. Есть и другие, но их эффективность – под вопросом. В большинстве случаев тратить на них время не стоит, если только проиндексировать сайт нужно срочно, и вы готовы испробовать любые способы. В таких случаях лучше читать конкретные кейсы. Например, как проиндексировать сайт в Google в течение 24 часов.

Вывод

Индексация сайта – сложный процесс, с которым поисковые системы далеко не всегда справляются в одиночку. Так как индексирование влияет непосредственно на ранжирование сайта в поисковой выдаче, имеет смысл взять управление в свои руки и максимально упростить работу поисковым роботам. Да, придется повозиться и набить много шишек, но даже такой непредсказуемый зверь как поисковый бот все же может покориться человеку.

В Google и «Яндексе», соцсетях, рассылках, на видеоплатформах, у блогеров